Linux 全解:新手到大神必备,100 + 常见问题 + 实战方案一站式搞定

Linux 全解:新手到大神必备,100 + 常见问题 + 实战方案一站式搞定

Prorise第一章: 破局:为什么 WSL 2 是现代化 Windows 开发的唯一答案

摘要: 本章将直面每一位挣扎于 Windows 环境的现代化开发者所共有的痛点——开发与生产环境的割裂。我们将系统性地剖析双系统、传统虚拟机乃至第一代 WSL 的历史局限性,并从核心架构层面揭示为何 WSL 2 凭借其 真实的 Linux 内核,彻底终结了这场旷日持久的“环境之战”。读完本章,您将不再有任何纠结与彷徨,并确信 WSL 2 正是那把开启高效、无缝开发体验的钥匙。

在本章中,我们将踏上一段拨云见日的旅程,彻底解决困扰您许久的平台选择难题:

- 首先,我们将深入 痛点 的根源,理解为何 Windows 原生环境会让现代开发者感到力不从心。

- 接着,我们将对双系统、虚拟机等 传统解决方案 进行一次“盖棺定论”的复盘。

- 然后,我们将从核心架构层面,揭开 WSL 2 的神秘面纱,理解其革命性的本质。

- 最后,我们将给出本指南的 终极承诺,展望一个两全其美的开发新世界。

1.1. 痛点共鸣:Windows 开发者的“环境割裂”之殇

作为一名追求高效与现代化的开发者,我们都曾被同一个魔咒所困扰:一句无奈的“在我电脑上是好的啊!”,背后是无尽的调试与挫败。一个应用,在我们的 Windows 开发机上运行得天衣无缝,可一旦部署到线上的 Linux 服务器,各种诡异的权限错误、路径问题、依赖冲突便接踵而至。

这并非偶然,其根源在于 开发环境与生产环境之间存在着一道深刻的哲学鸿沟。

Windows 的世界,是一个精心包装的礼盒。 它的设计哲学是面向大众,它认为“用户无需了解内部构造,只需享受便捷即可”。因此,它将复杂的系统底层封装起来,为我们提供了美观、易用的图形界面。这对于日常办公、娱乐而言,无疑是完美的。但对于开发者,这份“体贴”却成了一堵墙。当程序出错时,我们得到的往往是一个模糊的错误码,想深入探究,却发现无门可入。我们就像在盒子外调试,充满了猜测与不确定性。

Linux 的世界,则是一个完全透明的引擎室。 它的哲学截然相反,它相信“用户是专家,应拥有完全的控制权,并为自己的行为负责”。它向我们毫无保留地开放了系统的每一个角落,赋予了我们极致的自由。这份透明,正是开发者梦寐以求的——任何问题都有迹可循,任何行为都有精确的日志反馈。这种强大的确定性,是构建可靠系统的基石。

多年以来,我们就在这道鸿沟的两岸徘徊。我们享受着 Windows 桌面生态带来的便利——强大的 IDE (如 VS Code)、丰富的 GUI 工具、成熟的商业软件生态;但内心深处,我们又无比渴望 Linux 环境的自由、高效与标准统一,因为我们深知,那里才是我们代码最终的归宿。为了跨越这道鸿沟,开发者社区进行了长达数十年的艰苦探索。

1.2. 历史的终结:传统解决方案的局限性

在 WSL 2 横空出世之前,我们为了在 Windows 上“拥抱” Linux,尝试了各种方法。现在回过头看,每一种都是一次充满妥协的挣扎。

1.2.1. 方案一:双系统 (Dual Boot) - 割裂的选择

这是最直接的方案:在不同的硬盘分区上同时安装 Windows 和 Linux,开机时进行选择。

- 优点: 性能可以发挥到极致,两个系统都能完整地利用硬件资源。

- 致命缺陷: 工作流的彻底割裂。想象一下,你正在 Linux 中沉浸式地编写代码,突然需要查阅一个

PSD设计稿,或者回复一封必须使用 Outlook 特定插件的邮件。此刻,你唯一的选择就是:保存所有工作,重启电脑,等待 Windows 启动,完成任务后,再次重启,回到 Linux。每一次切换都是一次漫长而痛苦的打断,这对于追求“心流”状态的开发者而言,是无法忍受的。

1.2.2. 方案二:传统虚拟机 (VMware/VirtualBox) - 笨重的隔离

我们很快转向了虚拟机,试图在 Windows 系统内运行一个完整的 Linux。

- 优点: 无需重启即可同时运行两个系统,实现了基本的“共存”。

- 致命缺陷: 笨重与性能损耗。虚拟机就像在房子里又盖了一个小房子,它需要预先“圈占”一块内存和 CPU 资源,无论你是否正在使用它,这些资源都被锁定。它启动缓慢,运行卡顿,并且 Windows 与虚拟机内的 Linux 之间始终存在着一层厚厚的“结界”——文件共享需要繁琐的配置,网络设置令人头疼,甚至连简单的复制粘贴都时常失灵。这种体验,远非“无缝”。

1.2.3. 方案三:WSL 1 - 勇敢但“天真”的翻译官

微软也意识到了这个问题,推出了第一代 WSL (Windows Subsystem for Linux)。它的思路很巧妙:与其运行一个完整的 Linux,不如在 Windows 内核之上构建一个“翻译层”,将 Linux 的系统调用 实时翻译 成 Windows 的等效调用。

- 优点: 启动飞快,与 Windows 文件系统交互非常流畅。

- 致命缺陷: 不完整的兼容性。问题在于,“翻译”总有失真的地方。当遇到一些 Linux 独有、而 Windows 中没有直接对应物的复杂系统调用时(例如 Docker 容器技术所依赖的底层特性),这个“翻译官”就束手无策了。这正是许多早期用户发现连 Nginx、Docker 都无法正常运行的根本原因。它更像一个强大的 Linux 命令模拟器,而非一个可以信赖的、完整的 Linux 开发环境。

回顾: 以上所有方案,都在强迫我们做出痛苦的妥协:要么牺牲工作流的连贯性(双系统),要么牺牲系统性能和操作体验(虚拟机),要么就得忍受一个不完整的、随时可能“掉链子”的模拟环境(WSL 1)。我们想要的,是一个两全其美的方案。

1.3. 核心架构揭秘:WSL 2 的革命性突破

在深刻吸取了 WSL 1 的经验教训后,微软意识到,“翻译”这条路走不通。于是,他们带来了 WSL 2——一个从根本上改变游戏规则的全新架构。

WSL 2 不再做翻译,它直接在 Windows 系统中,内置了一个 真实的、完整的、由微软官方编译的 Linux 内核。

这个内核,运行在一个经过极致优化的、轻量级的 Hyper-V 虚拟机 之上。请不要被“虚拟机”这个词吓到,它和我们之前提到的笨重的 VMware 完全是两码事。这个特殊的虚拟机经过深度定制,与 Windows 宿主系统实现了前所未有的融合。

这场从“翻译”到“原生”的架构革命,带来了几个决定性的优势:

- 100% 的系统调用兼容性: 既然运行的是一个货真价实的 Linux 内核,那么任何能在原生 Linux 上运行的程序,现在都能在 WSL 2 中完美运行。Docker、Kubernetes、KVM… 所有这些曾经的“老大难”问题,如今都迎刃而解。

- 闪电般的启动速度: 这个轻量级虚拟机被优化到了极致,启动一个 WSL 2 发行版通常只需要一到两秒,其体验与打开一个普通的终端应用几乎没有差别。

- 无缝的跨系统集成: 这正是微软的魔力所在。你可以在 Windows 的文件资源管理器中,像访问普通文件夹一样直接访问和修改 Linux 子系统内的文件;反之,你也可以在 Linux 终端里,直接调用并执行 Windows 下的程序(比如我们稍后会用到的

code .命令)。两个世界之间的壁垒,被彻底打破。

1.4. 性能与兼容性的双赢

WSL 2 不仅解决了兼容性的根本问题,更是在开发者最关心的性能指标上实现了巨大飞跃,尤其是在文件 I/O 方面。

| 对比维度 | WSL 1 (翻译层) | WSL 2 (真实内核) | 核心优势解读 |

|---|---|---|---|

| 系统调用兼容性 | 不完全兼容,Docker 等工具无法运行 | 100% 完整兼容 | (推荐) 这是决定性的胜利,意味着您可以无障碍地拥抱整个云原生开发生态。 |

| 文件 I/O (在 Linux 文件系统内) | 较慢 | 速度提升 5-20 倍 | (推荐) git clone 一个大型仓库、npm install 数百个依赖包,这些日常操作的耗时将大幅缩短。 |

| 文件 I/O (跨系统访问) | 极快 | 较慢 | 这是 WSL 2 唯一的性能妥协点,但我们有完美的最佳实践来规避它。 |

性能黄金法则: 正如上表所示,为了发挥 WSL 2 的最大潜能,我们必须遵循一条黄金法则:始终将您的项目代码和文件,存储在 Linux 文件系统内部(例如 ~/projects 目录),并在此处进行所有操作。 绝对避免通过 /mnt/c/Users/... 这样的路径去操作位于 Windows 盘符下的项目。我们将在后续章节中,将这一法则融入到我们的工作流中。

1.5. 本指南的承诺:铸就终极开发环境

看到这里,答案已经昭然若揭。WSL 2 并非又一个需要我们妥协的折衷方案,而是那个我们期待已久的、集两个世界优点于一身的“集大成者”。

我们的目标与承诺:

通过本指南,我们将一步步引导您,亲手利用 WSL 2 打造一个 终极开发环境。在这个环境中,您将同时拥有:

- Windows 丰富、稳定且高效的桌面应用生态 (我们最爱的 VS Code、浏览器、设计工具、办公套件)。

- Linux 原生、完整且快如闪电的命令行与云原生能力。

最终,您得到的将是一个比 macOS 更具性价比和硬件自由度,比原生 Linux 桌面更省心、软件兼容性更好的强大生产力平台。从此,让我们告别环境的纠结与割裂,将全部精力,重新投入到创造本身。

理论的迷雾已经散去,前方的道路清晰无比。在下一章,我们将正式卷起袖子,进入激动人心的实战环节,用 20 分钟的时间,亲手为自己奠定这块未来可期的开发基石。

第二章: 奠基:20 分钟构建一个“开箱即战”的 WSL 2 工作区

摘要: 在理论的曙光之后,本章将引领您进入激动人心的实战环节。我们将以最贴近真实场景的方式,手把手地完成 WSL 2 核心环境的搭建。这不仅仅是一份安装指南,更是一套 最佳实践的落地流程。我们将一起处理从系统检查、一键安装,到国内软件源配置、首次系统更新的每一个细节,并最终见证 VS Code 与 WSL 2 完美融合的“奇迹时刻”。完成本章后,您将拥有一个坚如磐石且运行如飞的 Linux 开发基座。

说明: 在上一章,我们确立了 WSL 2 作为我们终极方案的理论基石。现在,是时候将蓝图变为现实了。请跟随我的节奏,我们将共同完成这次至关重要的环境奠基。

在本章中,我们将并肩完成以下关键步骤:

- 准备工作: 确认我们的 Windows 系统和硬件已为 WSL 2 做好准备。

- 一键安装: 使用一条命令,完成 WSL 2 核心组件与 Ubuntu 发行版的自动化安装。

- 初始化配置: 进行首次启动,并创建属于您自己的 Linux 用户账户。

- 网络加速: (关键实践) 将 Ubuntu 的软件源更换为国内镜像,为后续操作提供“火箭般”的速度。

- 系统升级: 完成首次全面的系统更新,确保环境的安全与稳定。

- 连接 IDE: 将我们最熟悉的 VS Code 与刚刚诞生的 Linux 子系统无缝连接。

- 见证奇迹: 敲下

code .,亲身体验跨越系统边界的开发流程。

2.1. 硬件与系统前置检查

在开始之前,我们需要确保我们的“主战场”——Windows 系统,已经准备就绪。这就像赛车手在发车前检查赛车一样,简单但至关重要。

2.1.1. 确认 Windows 版本

WSL 2 是在 Windows 10 的一个较新版本中才被引入的。我们需要确保您的系统版本不低于 20H1 (内部版本号 19041)。

操作非常简单:

- 按下键盘上的 Win + R 组合键,打开“运行”对话框。

- 输入

winver并按回车。

您会看到一个关于 Windows 的弹窗。请检查其中的版本号,只要它大于或等于 2004 (即 20H1) 或 19041,就说明您的系统满足要求。如果您正在使用 Windows 11,那么系统已全面原生支持,更无需担心。

2.1.2. 检查 CPU 虚拟化

WSL 2 的核心是轻量级虚拟化,这需要 CPU 提供硬件层面的支持,它允许操作系统高效、安全地将物理硬件资源(如 CPU 核心、内存)划分给多个隔离的运行环境。好消息是,近十年内生产的绝大多数 CPU 都默认支持并开启了此功能。我们只需快速确认一下。

- 按下 Ctrl + Shift + Esc 组合键,打开任务管理器。

- 切换到“性能”选项卡。

- 点击左侧的“CPU”。

- 在右侧信息的右下角,找到“虚拟化”一项。

如果显示“已启用”,那么恭喜您,一切准备就绪。

万一虚拟化未启用怎么办?

这种情况比较少见。如果确实未启用,您需要重启电脑并进入 BIOS/UEFI 设置。在其中寻找类似 “Intel® Virtualization Technology (VT-x)” 或 “AMD-V” 这样的选项,并将其设置为 Enabled。由于各主板厂商的界面不同,具体操作建议您根据自己的主板型号快速搜索一下相关教程。

2.2. 一行命令的魔力

过去,安装 WSL 需要在控制面板中手动开关多个 Windows 功能,过程相对繁琐。但现在,微软已经将这个过程封装成了一条强大而简洁的命令。

请以 管理员身份 打开您的终端。您可以右键点击“开始”菜单,选择“终端(管理员)”或“Windows PowerShell (管理员)”。

然后,在弹出的蓝底或黑底窗口中,输入并执行以下命令:

1 | wsl --install -d Ubuntu-24.04 |

这条命令看似简单,实则是一个强大的宏。它在后台为您执行了一系列复杂的管理任务:

wsl: 调用 WSL 命令行工具,是您未来管理所有子系统的入口。--install: 启动自动化安装流程。它会智能地检查并开启所有必需的 Windows 功能,如“虚拟机平台”和“适用于 Linux 的 Windows 子系统”,让您免于手动配置的烦恼。-d Ubuntu-24.04: 指定您想要安装的 Linux 发行版 (d是--distribution的简写)。我们选择Ubuntu-24.04,因为它是 Canonical 公司在 2025 年 最新的长期支持版本(LTS)。这意味着它将获得长达五年的官方安全更新和社区支持,是兼顾新特性与稳定性的最佳选择。

按下回车后,您会看到终端开始自动执行一系列任务:下载最新的 WSL 内核、安装 Ubuntu 发行版… 这个过程可能会持续几分钟,具体取决于您的网络速度。

安装完成后,终端会提示您 重启计算机 以使所有更改生效。请保存好您手头的工作,然后从容地重启电脑。

2.3. 首次启动与用户初始化

当您的电脑重启完成后,一个 Ubuntu 的终端窗口通常会自动弹出,并显示 “Installing, this may take a few minutes…”。这是 WSL 在为您进行最后的个性化配置。

稍等片刻,您将被要求创建一个 UNIX 用户账户。

1 | Please create a default UNIX user account. The username does not need to match your Windows username. |

这里是您在 Linux 世界的“创世纪”时刻,请务必注意:

- 输入您的用户名: 建议使用全小写、简洁的英文名,例如

prorise。这个用户名将是您在 Linux 世界里的身份标识。 - 输入您的密码: 接着,系统会提示您输入并确认密码。

密码输入时屏幕上不会有任何显示!

这是 Linux 及所有类 Unix 系统出于安全考虑的悠久传统。当您输入密码时,光标不会移动,也不会出现 * 号。请不要怀疑是键盘坏了,只需凭感觉盲打,输入完毕后按回车即可。这个密码至关重要,未来您执行所有需要管理员权限的 sudo 命令时,都必须输入它。

当您看到类似下面的欢迎信息时,就代表您的 Ubuntu 子系统已经安装并初始化成功了!

1 | Installation successful! |

1

prorise@YourPCName:~$

这个 prorise@YourPCName:~$ 就是您在 Linux 世界的家,我们称之为命令提示符 (Prompt)。

2.4. 【关键实践】换源:为你的 apt 安装火箭引擎

在正式开始使用前,还有一步至关重要的优化。Ubuntu 使用名为 apt 的工具来安装和管理软件,它会从一些默认的官方服务器(通常在欧洲或美国)下载软件包。由于地理位置和网络的原因,直接连接这些服务器的速度可能会非常缓慢。

为了解决这个问题,我们需要将 apt 的软件源更换为国内的镜像服务器,例如阿里云、清华大学等提供的镜像。这将使我们的软件安装速度提升数十倍。

2.4.1. 备份默认源

永远要对修改系统核心配置文件保持敬畏。在修改前,我们先备份一下原始的 sources.list 文件,以防万一:

1 | sudo cp /etc/apt/sources.list /etc/apt/sources.list.bak |

系统会要求您输入刚刚设置的 Linux 密码。输入后,这个命令会将原始的源文件复制一份,命名为 sources.list.bak。

2.4.2. 使用 Vim 编辑源文件

接下来,我们将使用 Vim 来编辑配置文件。Vim 是 Linux 环境下最强大、最普遍的文本编辑器,熟练掌握它将使您受益终身。

1 | sudo vim /etc/apt/sources.list |

执行后,您会进入 Vim 的界面。请不要慌张,Vim 有不同的“模式”,现在您正处于 普通模式 (Normal Mode),按键会被解释为命令。

第一步:清空文件

为了确保万无一失,我们先清空整个文件。在键盘上依次按下 g g d G。

gg: 将光标移动到文件的第一行。dG: 删除从当前行到文件末尾的所有内容。

第二步:进入插入模式

现在文件已经清空,按下键盘上的 i 键。您会发现窗口左下角出现了 -- INSERT -- 字样。这表示您已进入 插入模式 (Insert Mode),现在 Vim 的行为就和记事本一样了。

第三步:粘贴新的源地址

复制下面由 阿里云 提供的 Ubuntu 24.04 镜像源配置,然后在 Vim 窗口中 单击鼠标右键,即可粘贴。

1 | # 阿里云镜像源 for Ubuntu 24.04 LTS |

第四步:保存并退出

内容粘贴好后,按下键盘左上角的 Esc 键,左下角的 -- INSERT -- 会消失,表示您已退回到 普通模式。然后,输入冒号、w、q,即 :wq,再按回车。

:: 唤起命令栏。w: write,写入、保存。q: quit,退出。

恭喜,您已经完成了第一次 Vim 操作,并成功更换了软件源!

2.5. 【关键实践】执行首次全面系统升级

更换了高速源之后,我们立刻来执行一次全面的系统更新,以确保所有的软件包都更新到最新版本,修复潜在的安全漏洞。

在您的 Ubuntu 终端里,执行以下命令:

1 | sudo apt update && sudo apt full-upgrade -y |

1

2

3

4

5

6

7

8

9

10

11

12

13

Hit:1 http://mirrors.aliyun.com/ubuntu noble InRelease

Get:2 http://mirrors.aliyun.com/ubuntu noble-updates InRelease [114 kB]

Get:3 http://mirrors.aliyun.com/ubuntu noble-backports InRelease [90.7 kB]

...

Reading package lists... Done

Building dependency tree... Done

Reading state information... Done

Calculating upgrade... Done

...

The following packages will be upgraded:

... (此处会列出需要升级的软件包列表) ...

...

0 upgraded, 0 newly installed, 0 to remove and 0 not upgraded.

apt update 会首先从阿里云服务器获取最新的软件包信息列表。apt full-upgrade 则会根据这个列表,将您系统中所有可升级的软件都更新到最新版。得益于国内镜像,这个过程通常会非常迅速。

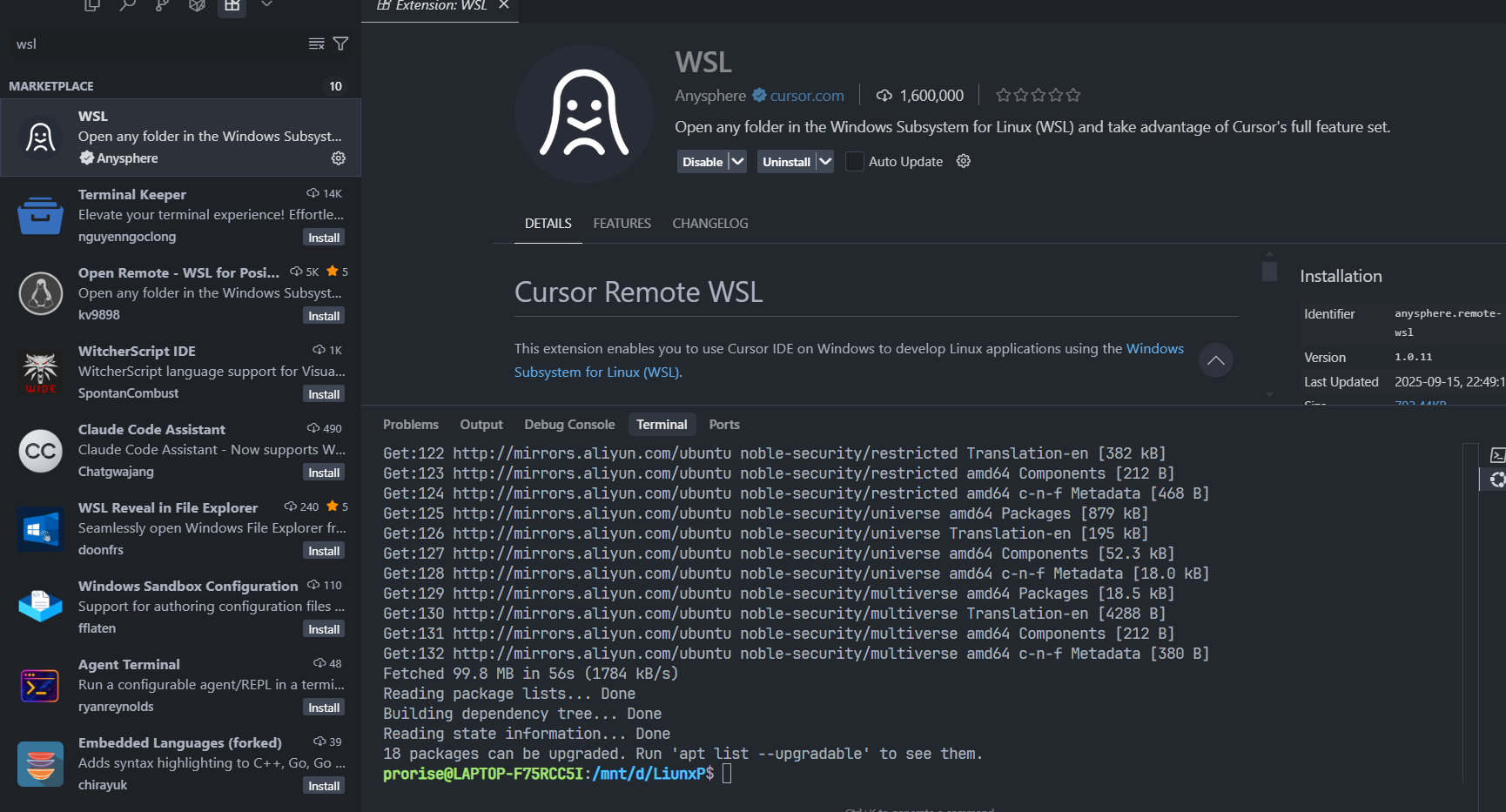

2.6. 搭建魔法之桥:安装 VS Code 的 “WSL” 扩展

这座连接 Windows 与 Linux 的“魔法之桥”,就是 VS Code 的官方 “WSL” 扩展。

前提: 请确保您已经在 Windows 侧安装了 Visual Studio Code。

- 打开 VS Code。

- 点击左侧边栏的“扩展”图标 (看起来像四个方块,快捷键

Ctrl+Shift+X)。 - 在搜索框中输入

WSL。 - 找到由 Microsoft 发布的那个扩展,它通常是第一个结果,然后点击 “安装”。

安装过程很快。这个扩展会自动在你的 Linux 子系统中配置一个轻量级的 vscode-server。正是这个精巧的客户端-服务器架构,实现了跨越系统边界的无缝体验。

2.7. 第一次跨越:在正确的位置启动 VS Code

现在,我们将进行第一次,也是最关键的一次“穿越”。我们将学习如何从 WSL 终端,在正确的 Linux 文件系统内启动 VS Code 进行开发。

打开 Ubuntu 终端

启动后,您会发现默认路径通常位于/mnt/c/Users/YourWindowsUsername。这是一个为了方便文件交换而设置的起点,但直接在此处进行开发会 极其缓慢。因此,我们的第一步永远是前往正确的工作区。导航至 Linux 的专属工作区

在 Linux 中,所有工作的起点都应该是您的专属“家目录”。这是一个位于 Linux 原生文件系统中的、高性能的安全区域。1

2# 无论当前在哪,立刻使用此命令回到家目录

cd ~cd是切换目录(Change Directory)的命令,而~(波浪号) 是家目录的永久快捷方式,其完整路径为/home/your_username。执行后,您会看到命令提示符变为一个简洁的~,代表您已抵达。建立规范的项目结构

一个良好的习惯是将所有项目代码存放在一个统一的目录中。让我们在家目录~下创建一个名为projects的文件夹,并为我们的第一个项目创建目录。1

2

3

4

5

6

7

8# 在家目录下,创建一个名为 projects 的文件夹

mkdir projects

# 进入 projects 文件夹

cd projects

# 为我们的第一个项目创建目录

mkdir my-first-project

# 进入该项目目录

cd my-first-project现在,您的终端路径应为

~/projects/my-first-project。这是一个完美的、高性能的开发起点。从 Linux 启动 VS Code

在当前的项目目录内,执行以下核心命令:1

code .

这个命令的含义是:请求在当前目录(由

.这个符号代表)的上下文中,启动 VS Code。首次运行时,VS Code 会在 Ubuntu 中自动安装一个轻量级服务vscode-server,此过程只需几十秒。安装完成后,一个崭新的 VS Code 窗口将在您的 Windows 桌面上打开,但它的核心已经与您的 Linux 环境深度链接。

2.8. 深度解析:理解“真·跨系统开发”的含义

这个新打开的 VS Code 窗口看似普通,但实际上蕴含着跨系统开发的魔力。请留意以下几个关键特征:

左下角的绿色连接指示器

窗口左下角会有一个显著的绿色标志,上面写着WSL: Ubuntu。这是一个重要的状态指示,它明确地告诉您:当前 VS Code 窗口正作为一个远程客户端,其所有的文件操作、命令执行和程序运行,都发生于后端的 WSL Ubuntu 环境中。无缝集成的原生 Linux 终端

使用快捷键 Ctrl + ` (反引号键) 打开 VS Code 的集成终端。您会发现,这已经是一个功能完整的、原生的 Ubuntu 终端,并且其默认路径就是我们刚刚创建的/home/your_username/projects/my-first-project。您可以在这里直接执行任何Linux命令,如ls -l,touch test.txt等,其效果与直接在独立的 Ubuntu 终端窗口中操作完全一致。文件系统位于高性能的 Linux 区

在 VS Code 左侧的文件浏览器中,右键点击空白处,选择“新建文件”,命名为hello.js。随即在下方的集成终端中输入ls命令并回车,您会看到hello.js被列出。接着输入pwd命令(Print Working Directory,打印当前工作目录),终端会返回/home/your_username/projects/my-first-project。这证明了您通过图形界面创建的文件,被真实地、高性能地存储在了 Linux 的原生文件系统内。

核心理念总结:

您使用的是 Windows 的 VS Code (享受着流畅的 UI、丰富的插件生态和熟悉的快捷键),但您的代码文件、依赖、编译器、调试器、终端,全部都 100% 运行在真实的 Linux 环境中。您获得了两个世界最好的部分,而几乎没有妥协。

2.9. 实战演练:体验高性能的 Node.js 工作流

让我们通过一个简单的 Node.js 示例,将所有概念串联起来,并直观地感受在正确位置开发的性能优势。

在 VS Code 集成终端中初始化项目

1

npm init -y

命令执行后,

package.json文件会瞬间出现在左侧文件浏览器中。安装项目依赖

1

npm install express

请特别留意此命令的执行速度。

node_modules目录的创建涉及数千个小文件的写入操作,这是一个对文件系统 I/O 性能的绝佳考验。因为我们身处 Linux 原生文件系统,这个过程会比在/mnt/c(Windows 盘) 下快数倍甚至数十倍。这正是 WSL 开发工作流的核心价值所在。创建并编辑服务器代码

在 VS Code 文件浏览器中,创建一个名为server.js的文件,并粘贴以下代码:1

2

3

4

5

6

7

8

9

10

11

12const express = require('express');

const app = express();

const port = 3000;

app.get('/', (req, res) => {

// 这条响应信息由在 Linux 中运行的 Node.js 服务发出

res.send('Hello from WSL 2! This is a REAL Linux server.');

});

app.listen(port, () => {

console.log(`Server running at http://localhost:${port}`);

});在集成终端中启动服务

1

node server.js

终端会显示服务已在

3000端口上运行。在 Windows 浏览器中验证结果

打开您在 Windows 系统中的任意网页浏览器(如 Chrome, Edge),访问地址http://localhost:3000。您将立刻看到页面显示 “Hello from WSL 2! This is a REAL Linux server.”。

原理解析: WSL 2 的网络系统具备端口自动转发的魔法。任何在 Linux 子系统内部监听 localhost (或 0.0.0.0) 的网络端口,都会被 WSL 自动、无缝地映射到 Windows 主机的 localhost 上。您无需进行任何手动的端口映射或网络配置,开发体验如同在原生 Windows 上一样自然流畅。

Cursor 作为一款集成了强大 AI 功能、基于 VS Code 的编辑器,同样可以与 WSL 2 实现无缝集成,其工作原理与 VS Code 完全一致。以下是在 Cursor 中启用 WSL 2 开发工作流的两种主要方法。

方法一:从 Cursor 界面连接到 WSL

这种方法适合喜欢图形化操作的用户。

安装 WSL 扩展

打开 Cursor,进入左侧的扩展市场视图,搜索 “WSL” 并安装由 Microsoft 提供的官方扩展。连接到 WSL

安装完成后,在 Cursor 窗口的左下角会看到一个蓝色的远程连接按钮(图标通常是><)。 点击该按钮,在弹出的命令面板中选择 “Connect to WSL” 或 “Connect to WSL using Distro…”。打开项目文件夹

连接成功后,Cursor 会重新加载,并允许你通过 “文件” > “打开文件夹…” 来浏览并打开位于 WSL Linux 文件系统(例如/home/your_username/projects)中的项目。

方法二:从 WSL 终端启动 Cursor (推荐)

这是最流畅、最可靠的方式,与 VS Code 的 code . 命令体验一致。

导航到项目目录

首先,在你的 Ubuntu (或其他发行版) 终端中,使用cd命令进入你的项目文件夹。1

cd ~/projects/my-first-project

启动 Cursor

在项目目录内,执行以下命令:1

cursor .

当你第一次运行此命令时,Cursor 会自动在你的 WSL 实例中安装一个名为

.cursor-server的轻量级服务,用于管理与 Windows 端 Cursor 的通信。 安装完成后,项目将在一个新的 Cursor 窗口中打开。验证连接

查看 Cursor 窗口左下角,如果显示WSL: Ubuntu(或你的发行版名称),则表示连接成功,你已经处在高性能的跨系统开发环境中。

疑难解答:cursor: command not found

如果在 WSL 终端中执行 cursor . 时遇到“命令未找到”的错误,这意味着 WSL 无法找到位于 Windows 系统中的 Cursor 可执行文件。

解决方案: 将 Cursor 的路径手动添加到 WSL 的 PATH 环境变量中。

编辑你的 Shell 配置文件

根据你使用的 Shell,打开对应的配置文件(~/.bashrc对应 Bash,~/.zshrc对应 Zsh)。1

2

3

4

5# 如果你使用 Bash

nano ~/.bashrc

# 如果你使用 Zsh

nano ~/.zshrc添加 PATH

在文件末尾添加以下行,注意 将<YourWindowsUsername>替换为你自己的 Windows 用户名。1

export PATH="$PATH:/mnt/c/Users/<YourWindowsUsername>/AppData/Local/Programs/cursor/resources/app/bin"

使其生效

保存文件后,执行以下命令使配置立即生效(或直接重启终端)。1

2

3

4

5# 如果你使用 Bash

source ~/.bashrc

# 如果你使用 Zsh

source ~/.zshrc现在,

cursor .命令应该可以在 WSL 终端的任何路径下正常工作了。

小技巧: 为了让习惯于 VS Code 的开发者更加方便,你还可以在 .bashrc 或 .zshrc 文件中设置一个别名,让输入 code . 时实际执行的是 cursor .。

1 | alias code='cursor' |

第三章:终端革命:Warp 从零到精通的快速上手指南

摘要: 欢迎来到下一代终端的世界!本章是您快速掌握 Warp 的实战手册。我们将从安装和首次配置开始,带您直接体验 Warp 的核心魅力。您将学习到它革命性的 现代文本输入 和 区块(Block)交互 模型,并掌握其“杀手级功能”——Warp AI,看它如何用自然语言为您生成和调试命令。我们还将通过实例教您创建 工作流(Workflows) 来终结重复性工作,并使用 命令面板 高效导航。本章旨在让您在最短的时间内,将 Warp 从一个新工具变为您日常开发中不可或缺的效率利器。

3.1. 安装与首次启动

下载与安装:

在您的 Windows 浏览器中,访问 Warp 的官方网站。网站会自动识别您的系统并提供下载链接。下载.msi安装包后,双击并按提示完成安装。登录账户:

首次启动 Warp,会提示您使用 GitHub 账户登录。强烈建议您完成此步骤,因为 Warp 的许多核心功能(如配置同步、团队协作)都依赖于云端账户。选择您的 Shell:

Warp 会自动检测您系统上安装的 Shell(如 Bash, Zsh, Fish)。对于 WSL 用户,它会直接连接到您默认的 Linux 发行版。

3.2. 核心交互:颠覆你对终端的认知

要快速上手,只需理解两个核心概念:输入区 和 区块。

3.2.1. 输入区:一个真正的代码编辑器

忘掉传统终端那简陋的单行输入吧。Warp 的底部输入区是一个现代化的编辑器。

- 多行编辑:可以直接按

Enter换行来编写复杂命令或粘贴代码片段,命令不会立即执行。 - 鼠标操作:可以用鼠标在任意位置点击、选择、复制和粘贴,就像在 VS Code 中一样。

- 执行命令:编写好命令后,按

Ctrl+Enter执行。

实战一下:在输入区粘贴以下多行命令,然后按

Ctrl+Enter执行,感受多行编辑的便利。

1 | for i in {1..3} |

3.2.2. 区块:命令与输出的独立单元

这是 Warp 最具标志性的功能。 每条执行的命令及其输出都会被打包成一个独立的“区块”。这让您的终端历史变得前所未有的清晰和强大。

- 轻松复制:将鼠标悬停在区块上,右上角会出现按钮,让您一键复制命令或输出。

- 分享与协作:点击区块右上角的链接图标,可以为这个区块创建一个永久链接(Permalink)。把链接发给同事,他们就能看到完整的命令和执行结果,是远程排错和知识分享的神器。

- 快速导航:使用

Ctrl+↑和Ctrl+↓可以在历史命令的区块之间快速穿梭。

3.3. 王牌功能:Warp AI 助你“人机合一”

Warp 内置了强大的 AI 功能,无论是新手还是专家,都能从中获益。

3.3.1. 自然语言生成命令

忘记了复杂的命令?没关系,直接问 AI。

如何使用:在输入区输入

#,然后用中文或英文描述你想做的事。实用案例:

- 想查找大文件?输入:

# 查找当前目录下所有大于 500MB 的 .log 文件 - 需要解压文件?输入:

# 如何解压一个 .tar.gz 文件? - 复杂的 Git 操作?输入:

# git 命令:将过去 3 次的提交合并成一个

AI 会自动生成命令,你检查无误后按

Ctrl+Enter即可执行。- 想查找大文件?输入:

3.3.2. AI 辅助调试

命令执行出错了?Warp AI 帮你分析。

- 当一个命令的区块包含错误信息时,区块右上角会出现一个“Debug with AI”的按钮。点击它,AI 会分析错误日志并给出可能的原因和解决方案。

3.4. 效率倍增器:工作流与命令面板

3.4.1. 工作流(Workflows):一劳永逸的自动化

将常用但复杂的命令保存为模板,方便随时调用。

- 打开命令面板:按下

Ctrl+P。 - 创建工作流:在面板中输入

Create Workflow并回车。 - 设置模板:

- Name: 给工作流起个易记的名字,例如

Git Commit with Message。 - Command: 输入命令模板,用

{{argument_name}}来定义参数。例如:1

git commit -m "{{commit_message}}"

- Name: 给工作流起个易记的名字,例如

- 使用工作流:

- 按下

Ctrl+P,输入你刚才起的名字(如Git Commit)。 - 选中它并回车,Warp 会弹出一个输入框,让你填写

commit_message的值。

- 按下

3.4.2. 命令面板(Ctrl + P):你的指挥中心

这是 Warp 的中枢神经。按下 Ctrl + P,你可以:

- 搜索历史命令:模糊搜索你执行过的任何命令。

- 查找功能:想分屏?输入

split pane就能找到对应功能。 - 执行工作流:直接输入工作流的名字来调用。

第四章:进入 Linux 的世界 —— 核心理念与生态系统

摘要: 在前三章中,我们已经成功地在 Windows 上构建了一个无缝、高效的 WSL 2 开发环境。现在,是时候从“术”的层面,深入到“道”的层面了。在本章,我们将暂停学习具体的命令,转而探索 Linux 的核心设计哲学、庞大的发行版家族,以及支撑其生态系统运转的包管理机制。理解这些,将帮助您不仅仅是“会用”Linux,而是真正“理解”Linux,为您后续的精通之路打下坚实的基础。

本章地图在本章中,我们将从宏观到微观,逐步揭开 Linux 的神秘面纱:

- 首先,我们将探讨 为何要学 Linux,明确其在现代开发中不可替代的价值。

- 接着,我们将深入其 核心设计哲学,通过与 Windows 的对比,理解其“自由与责任”的本质。

- 然后,我们将漫游庞大的 Linux 家族,了解各大发行版的特点,并阐明为何我们选择 Ubuntu 作为教学环境。

- 最后,我们将揭秘之前安装软件的“魔法”——包管理器,并对比

apt与yum/rpm的区别。

4.1. 为何要学 Linux:现代开发者的必然选择

在前面的章节中,我们花费了大量精力,就是为了在您熟悉的 Windows 系统中,无缝地“植入”一个完整的、原生的 Linux 环境。现在,我们正式踏入这片新大陆,首先要解决一个根本问题:我们为什么要来这里?

痛点背景: 许多开发者,尤其是在 Windows 环境下成长起来的,会觉得现有的图形化工具已经足够高效,学习一个全新的、以命令行交互为主的操作系统似乎投入产出比不高。甚至在程序员群体中,还流传着 macOS -> Linux -> Windows 这样的“操作系统鄙视链”,让人望而却步。

解决方案: 我们需要摒弃这种简单粗暴的比较。选择操作系统的关键在于生产力与应用场景。对于现代后端与全栈开发者而言,学习 Linux 并非为了“炫技”或“跟风”,而是源于一个最朴素、最务实的需求:我们的代码,最终要运行在 Linux 服务器上。

绝大多数的云服务器、容器、以及自动化部署流水线都构建在 Linux 之上。在 Windows 上开发,然后在 Linux 上部署,就像在淡水里训练,却要去海水里比赛,水土不服是必然的。而在 WSL 2 中学习和使用 Linux,就是为了搭建一个与线上环境高度一致的“全真模拟训练场”,从根源上消除环境差异带来的不确定性。

最佳学习方式:沉浸式使用

学习 Linux 最好的方式,就是直接去用它!我们已经为您搭建了完美的 WSL 2 环境,这意味着您无需放弃 Windows 的便利,就能将日常开发工作流逐步迁移到 Linux 命令行中。一开始可能会感到蹩脚和不适,这很正常。如果你一直感到很舒服,只能说明你一直没有进步。将在后续章节学习到的每一个命令,都请立即在您的 WSL 终端中敲击并验证它,这才是最高效的学习路径。

4.2. 导航两个世界:我在哪里?我的文件该放哪里?

这是您接触 WSL 时遇到的第一个,也是最核心的问题。理解了文件系统的交互,您后续的所有操作才会得心应手。

4.2.1. 初次见面:理解你当前的位置 /mnt/c/...

当您第一次打开安装好的 Ubuntu 终端时,您会发现您的命令提示符可能显示在一个很长的路径下,例如:your_username@hostname:/mnt/c/Users/YourWindowsUsername$

请立刻认识到:这是一个陷阱!

这是哪里?

/mnt/c是 WSL 为了方便,提供的一个指向您 Windows 系统 C 盘 的“快捷方式”或“传送门”。所以,您当前正处于 Linux 环境中,但您的“脚”正踩在 Windows 的地盘上。为什么是陷阱?

虽然能在这里直接访问 Windows 文件很方便,但通过这个“传送门”进行的所有文件操作(比如npm install、git clone、编译代码)都 极其缓慢。因为这需要 Linux 和 Windows 两个操作系统进行实时、复杂的跨系统文件翻译,性能会下降几个数量级。

4.2.2. 第一条黄金指令:回家!

在 Linux 中,每个用户都有一个专属的“家目录”,它是一切工作的起点。我们必须立刻回到这里。

执行“回家”命令:

无论您当前在多么复杂的路径下,只需输入以下命令并回车:1

cd ~

cd是Change Directory(切换目录) 的缩写。~(波浪号) 是一个特殊的快捷符号,在 Linux 中永远代表 当前用户的家目录。它的完整路径是/home/your_username。

观察变化:

执行命令后,您的命令提示符会立刻变得非常简洁:your_username@hostname:~$

这个~符号明确地告诉您:您已安全抵达 Linux 的家目录。 这里就是您的专属地盘。

性能与安全的黄金法则

所有开发项目、代码仓库、数据库文件等一切需要频繁读写的文件,都必须、必须、必须存放在您的 Linux 家目录 ~ 内部! (例如,我们可以创建一个 ~/projects 文件夹来存放所有代码)。永远不要在 /mnt/c 或其他挂载的 Windows 盘符下进行开发工作。

为了方便后续工作,让我们立刻在“家”里建一个专门放项目的地方:

1 | # 在家目录(~)下,创建一个名为 projects 的文件夹 |

现在,您的路径是 ~/projects,这是未来所有开发工作的理想起点。

4.2.3. 揭秘幕后:两个世界的交互机制

现在您已经处在正确的位置了,我们可以安心地来理解这背后的原理。

机制:通过 /mnt/ 目录挂载

WSL 会自动将您 Windows 的所有硬盘分区“挂载”到 Linux 的 /mnt/ 目录下,让您可以从 Linux 中访问它们。

- 您的 C 盘

C:\-> 被映射为/mnt/c - 您的 D 盘

D:\-> 被映射为/mnt/d

这个过程依赖一个名为 9P 的网络文件协议。您可以把它想象成 Linux 和 Windows 之间建立了一个内部的网络连接来传输文件。正因为涉及网络通信和协议转换,所以通过这种方式访问文件会 慢。

适用场景:仅用于临时读取或拷贝 Windows 下的个别文件(如下载好的压缩包、文档等)到 Linux 环境中。严禁在此处运行项目。

机制:通过网络路径 \\wsl$ 访问

这是一个对零基础用户来说 必须掌握 的关键技巧!您可能想问:“我放在 Linux ~/projects 里的代码,怎么用 Windows 里的 VS Code 打开呢?” 答案就在这里。

WSL 2 在 Windows 中创建了一个特殊的网络路径,让您可以像访问局域网共享文件夹一样,高速访问 Linux 内部的文件。

- 打开 Windows 的 文件资源管理器。

- 在顶部的地址栏中,输入以下内容并按回车:

1

\\wsl$

- 您会看到一个名为

Ubuntu(或其他发行版名称) 的文件夹。 - 双击进入

Ubuntu文件夹,然后依次进入home->your_username->projects。

看到了吗?您在 Linux 中创建的所有文件和文件夹,都清晰地展现在了 Windows 的文件资源管理器中!

这种访问方式 性能极高,因为它经过了特殊优化。当您使用 VS Code 的 WSL 插件打开 ~/projects 文件夹时,VS Code 正是通过这个 \\wsl$ 路径在后台与您的 Linux 文件进行交互的,从而实现了无缝、流畅的开发体验。

这个 \\wsl$ 背后,才是我们之前提到的那个大型虚拟硬盘文件 ext4.vhdx。Windows 通过 \\wsl$ 这个友好的“前端”,让您能直接、高性能地操作 ext4.vhdx 这个“后端”里的真实数据。

4.3. Linux 家族:发行版与我们的选择

- Linux 内核 (Kernel):由林纳斯·托瓦兹创造的操作系统核心,负责管理硬件、内存、进程等。它是所有 Linux 系统的“发动机”。

- GNU 工具集:由理查德·斯托曼的 GNU 项目发起,提供了 `ls`, `cp`, `bash` 等海量的命令行工具。它是操作系统的“车身和仪表盘”。

- Linux 发行版 (Distribution):将 Linux 内核与 GNU 工具集、以及其他应用软件(如图形界面、办公套件)打包整合,并提供安装界面和包管理机制,形成的一个完整的操作系统。

当我们说“安装 Linux”时,我们实际上安装的是一个“Linux 发行版”。市面上有成百上千的发行版,但它们都共享同一个 Linux 内核。

Linux 操作系统内核缔造者:林纳斯·托瓦兹 (Linus Torvalds)

GNU 项目发起人、自由软件基金会创办人:理查德·斯托曼 (Richard Stallman)

主流发行版家族:

| 家族 | 代表发行版 | 主要特点 | 包管理器 | 核心应用领域 |

|---|---|---|---|---|

| Debian 系 | Debian, Ubuntu, Mint | 庞大的软件库,强大的社区支持,对桌面和开发者友好。 | apt (.deb) | 桌面、Web 服务器、云/容器环境 |

| Red Hat 系 | RHEL, CentOS, Fedora | 极致的稳定性,优秀的企业级支持,是传统服务器领域的王者。 | yum, dnf (.rpm) | 企业级服务器、数据中心 |

| SUSE 系 | openSUSE | 在欧洲非常流行,以其强大的 YaST 配置工具而闻名。 | zypper (.rpm) | 企业环境 |

| Arch 系 | Arch Linux | 滚动更新,高度可定制化,面向喜欢“折腾”的高级用户。 | pacman | 极客、高级用户桌面 |

为何我们的教程选择 Ubuntu?

尽管很多人推荐 CentOS,因为它在线上服务器中占有率很高。但在 2025 年的今天,特别是对于我们“务实的现代化开发者”而言,选择 Ubuntu 作为 WSL 的学习和开发环境是更优解:

- 开发者生态压倒性优势:Ubuntu 的 `apt` 软件源拥有最新、最全的开发工具包。您想用的几乎所有新潮工具,都能在 Ubuntu 中轻松 `apt install`,而 CentOS 的 `yum` 源则相对保守和陈旧。

- 社区与文档最丰富:遇到任何问题,用“Ubuntu + 问题描述”去搜索,您能找到的解决方案远多于其他发行版。

- 云与容器时代的标准:绝大多数官方 Docker 镜像都基于 Debian 或 Ubuntu 构建。在云原生时代,Ubuntu 的影响力正变得越来越大。

- WSL 的官方默认:Windows 官方在安装 WSL 时,默认推荐的就是 Ubuntu,这保证了最佳的兼容性和开箱即用的体验。

我们的目标是在本地高效开发,而 Ubuntu 正是为此而生的最佳选择。

4.4. 生态的引擎:包管理器解析

本小节核心知识点:

- 包管理器:是 Linux 系统中用于自动化安装、升级、配置和卸载软件包的工具,它能自动处理棘手的“依赖关系”。

- APT (Advanced Packaging Tool):Debian/Ubuntu 体系的包管理工具,前端命令是 `apt` 或 `apt-get`,处理的是 `.deb` 格式的软件包。

- YUM/DNF & RPM:Red Hat/CentOS/Fedora 体系的包管理工具。`rpm` 是底层的软件包格式和安装工具,而 `yum` (或其现代替代品 `dnf`) 是更上层的、能自动解决依赖关系的工具。

在第三章中,我们用 sudo apt install zsh htop 这样的命令安装了软件。这个 apt 就是 Ubuntu 的包管理器。

痛点背景: 在没有包管理器的时代,在 Linux 上安装一个软件是一场噩梦。您需要:

- 手动去官网下载软件的源代码压缩包。

- 解压后阅读

README文件。 - 发现它依赖于 A、B、C 三个库,于是您又去下载这三个库的源码。

- 发现 A 库又依赖于 D、E 两个库… 陷入“依赖地狱”。

- 手动编译和安装所有这些依赖,最后才能编译和安装您最初想要的软件。

解决方案: 包管理器 的出现,彻底解决了这个问题。

它就像一个巨大的应用商店,您只需告诉它想要什么,它就会自动帮您搞定一切:

- 寻找正确的软件包版本。

- 下载该软件包。

- 检查并下载所有它依赖的其他软件包。

- 以正确的顺序安装所有内容。

- 还能轻松地更新和卸载。

主流包管理器对比:

| 包管理器 | 关联发行版 | 核心命令 | 软件包格式 | 特点 |

|---|---|---|---|---|

apt | Debian, Ubuntu | apt install, apt update | .deb | (推荐) 软件源极其丰富,更新快,是目前开发者社区的主流。 |

yum/dnf | CentOS, RHEL, Fedora | yum install, dnf install | .rpm | 稳定、可靠,在企业服务器环境中使用广泛,但软件版本通常较保守。 |

这就是为什么我们现在很少听到开发者讨论 rpm 和 yum,因为在云原生和现代开发的大潮中,基于 Debian/Ubuntu 和 apt 的生态系统已经占据了主导地位。

4.5. 本章核心速查总结

| 分类 | 关键项 | 核心描述 |

|---|---|---|

| 核心理念 | 环境一致性 | 本地使用 Linux (WSL) 是为了消除与生产环境的差异,是开发者的核心诉求。 |

| 设计哲学 | 自由与责任 | Linux 赋予用户完全的控制权,透明、强大,但要求用户为自己的操作负责。 |

| 核心组件 | 内核 + GNU 工具集 | Linux 操作系统 = Linux 内核 (发动机) + GNU 工具 (系统软件)。 |

| 生态单位 | 发行版 (Distribution) | 将内核、工具集和其他软件打包而成的完整操作系统,如 Ubuntu, CentOS。 |

| 教学选择 | Ubuntu (LTS) | (推荐) 开发者生态最丰富,社区支持最好,是 WSL 和云原生的首选。 |

| 软件管理 | 包管理器 | 自动化处理软件安装、依赖、更新和卸载的工具。 |

| 主流工具 | apt (Ubuntu) | (推荐) 对应 .deb 包,软件源更新快,工具链丰富。 |

| 主流工具 | yum/dnf (CentOS) | 对应 .rpm 包,以稳定性著称,在传统企业服务器中常见。 |

第五章:Linux 的文件系统:结构、标准与管理

本章旨在建立对 Linux 文件系统组织方式的根本理解。我们将从其设计的核心哲学出发,剖析其与 Windows 文件系统的结构性差异。随后,将以可视化的目录树形式,系统性地介绍遵循文件系统层次结构标准(FHS)的核心目录及其功能,阐明在 Windows Subsystem for Linux (WSL) 环境下与主机文件系统交互的机制,并最终掌握分析和管理磁盘空间的核心命令行工具。

5.1. 概念差异:Windows 的多根文件系统与 Linux 的统一根文件系统

Windows 与 Linux 在文件系统设计上的根本差异,是理解后者的第一步。

Windows 操作系统采用多根(Multi-Root)文件系统结构。系统的存储空间被划分为多个逻辑卷,并以“盘符”(Drive Letter)如 C:、D: 等进行标识。每一个盘符都是一个独立文件系统的起点或“根”,它们在逻辑上是并列的,形成了一个由多个独立文件树组成的集合。

与之相反,Linux 及其所有遵循 UNIX 设计哲学的操作系统,均采用单一、统一的树状文件系统结构。整个系统的唯一入口点是根目录(root directory),以一个正斜杠 / 表示。所有的存储设备,包括物理硬盘分区、USB 设备、网络驱动器等,都必须通过“挂载”(Mount)操作,关联到根文件树下的某个目录上,才能被访问。这个作为连接点的目录被称为“挂载点”(Mount Point)。

这一设计的核心是虚拟文件系统(Virtual File System, VFS)层,它提供了一个统一的抽象接口。无论底层硬件和文件系统类型为何(ext4, XFS, NTFS 等),VFS 都能使其以统一的方式呈现在根文件树下。这种“一切皆文件”的哲学延伸到了设备(如 /dev/sda)、进程间通信甚至内核参数,它们都在文件系统中拥有对应的节点。因此,在 Linux 中,我们关注的是文件在统一树状结构中的唯一路径,而非其所在的物理设备。

5.2. 文件系统层次结构标准 (Filesystem Hierarchy Standard, FHS)

为了保证不同 Linux 发行版之间的规范性、可预测性和互操作性,核心目录的组织遵循文件系统层次结构标准(FHS)。该标准定义了主要目录的用途,确保用户和软件都能可靠地找到所需的文件和资源。

以下是 Linux 核心目录结构的可视化树状图,及其详细功能阐述。

1 | / (root) |

目录功能详解

/ (根目录)

功能: 文件系统层次结构的起点。所有其他目录和文件都源于此。/bin (Essential User Binaries)

功能: 存放所有用户(包括普通用户)都能使用的核心系统命令。这些是系统启动和基本功能运行所必需的二进制可执行文件。

内容示例:ls,cp,mv,cat,bash。

开发者相关性: 您在终端中使用的最基础的命令大多位于此处。/sbin (Essential System Binaries)

功能: 存放仅供系统管理员(root 用户)使用的核心系统管理和维护命令。

内容示例:fdisk(磁盘分区),ip(网络配置),reboot,mkfs(创建文件系统)。

开发者相关性: 当您需要进行系统级的配置,如设置网络、管理磁盘或启动服务时,会用到这里的命令。

在许多现代 Linux 发行版中,为整合资源,/bin 和 /sbin 已成为指向 /usr/bin 和 /usr/sbin 的符号链接。

/etc (Etcetera - System-wide Configuration Files)

功能: 存放整个系统范围的、静态的配置文件。几乎所有系统服务和应用程序的全局配置都存储在此。

内容示例:/etc/nginx/nginx.conf(Nginx 配置),/etc/ssh/sshd_config(SSH 服务配置),/etc/fstab(文件系统挂载配置),/etc/passwd(用户账户信息)。

开发者相关性: 这是您作为开发者或运维人员最常打交道的目录之一。配置 Web 服务器、数据库、SSH 访问权限等都需要编辑此目录下的文件。/home (User Home Directories)

功能: 存放普通用户的个人数据、用户级别的配置文件和项目代码。每个用户在此目录下都有一个以其用户名命名的专属子目录。

内容示例:/home/your_username/projects,/home/your_username/.bashrc。

开发者相关性: 这是您主要的工作区域。所有开发项目、代码仓库、个人脚本和自定义的 Shell 配置都应存放在您的家目录中,即~(/home/<username>)。/root (Root User’s Home Directory)

功能: 超级用户root的专属家目录。将其与/home分离,是为了保证即使/home所在的分区出现问题,root用户依然能够登录并执行系统修复任务。/usr (Unix System Resources)

功能: 存放由操作系统发行版管理的、用户安装的应用程序、共享库文件和文档。可以将其视为系统的主软件库。

内容示例:/usr/bin: 绝大多数非核心的用户命令。/usr/lib: 应用程序和系统所需的共享库文件。/usr/local: 留给系统管理员用于手动安装软件的路径,以区别于通过包管理器安装的软件。

/var (Variable Files)

功能: 存放内容在系统正常运行过程中会持续变化的文件。

内容示例:/var/log: 系统和应用程序的日志文件。排查服务故障时必须查看这里。/var/cache: 应用程序的缓存数据,如包管理器的缓存。/var/lib: 应用程序的状态信息,如数据库的数据文件。/var/www: 某些 Web 服务器(如 Apache)默认的网站根目录。

/tmp (Temporary Files)

功能: 用于存放应用程序和用户创建的临时文件。系统重启后,此目录的内容通常会被清空。/dev (Device Files)

功能: 存放代表物理和虚拟硬件设备的特殊文件。例如,/dev/sda1可能代表第一个硬盘的第一个分区。/boot (Boot Loader Files)

功能: 包含启动 Linux 系统所需的核心文件,包括 Linux 内核 (vmlinuz)、初始 RAM 磁盘映像 (initrd) 以及引导加载程序(如 GRUB)的配置文件。/mnt (Mount point for temporarily mounted filesystems)

功能: 一个通用的、临时的挂载点目录,通常用于手动挂载外部设备(如 U 盘)以进行临时访问。

5.3. 跨系统边界:WSL 2 中的 /mnt 挂载点

现在,我们来解答在 WSL 环境下如何访问 Windows 文件的问题。这正是通过 /mnt 目录实现的。

WSL 2 启动时,会自动将 Windows 系统中的固定驱动器(如 C 盘、D 盘)挂载到 Linux 系统下的 /mnt 目录中。这是一个自动化的挂载过程,其命名规则是直接使用 Windows 盘符的小写形式作为目录名。

- Windows

C:\驱动器对应于 WSL 中的/mnt/c - Windows

D:\驱动器对应于 WSL 中的/mnt/d

这种跨文件系统的访问是通过一个名为 9P 的网络文件系统协议实现的。当您在 WSL 中对 /mnt/c 内的文件进行读写时,Linux 内核会将这些操作通过 9P 协议转发给 Windows 主机执行。

核心原则: 务必在 Linux 原生文件系统(如 /home/username/projects)内进行代码编译、依赖安装等 I/O 密集型开发工作。通过 /mnt/* 访问 Windows 文件会因协议转换产生显著的性能开销,导致操作异常缓慢。

5.4. 磁盘空间管理:df 与 du

熟悉文件系统布局后,管理其空间占用是必备技能。df 和 du 是两个互补的核心工具。

df:报告文件系统分区的使用情况

df(disk free)命令用于查看已挂载文件系统(即磁盘分区)的整体空间使用情况。

1 | # -h 选项以人类可读的格式 (如 G, M, K) 显示大小 |

典型输出解析:

1 | Filesystem Size Used Avail Use% Mounted on |

- Filesystem: 文件系统的来源,可以是设备名或远程路径。

- Size: 该文件系统的总容量。

- Mounted on: 该文件系统在 Linux 树状结构中的挂载点。

du:估算当前文件和目录的空间占用

du(disk usage)命令用于递归地计算目录或文件所占用的磁盘空间。它更侧重于微观的文件和目录级别。

1 | # 查看当前目录下,每个子目录和文件的总大小 |

典型输出解析:

1 | 4.0K another-project |

该输出清晰地列出了当前目录下每个项目占用的大小。

第六章:文件与目录操作:命令行中的“瑞士军刀”

本章将聚焦于 Linux 命令行中最核心、最频繁使用的文件与目录操作命令。掌握这些工具是高效进行系统管理和开发的基础。我们将从文件系统的基本导航开始,逐步深入到文件的创建、删除、复制、移动,并最终学习如何在庞大的文件系统中高效、精确地查找所需的文件和命令。

6.1. 导航三剑客:pwd, ls, cd

在文件系统的“大树”中自由穿梭是所有操作的前提。pwd、ls 和 cd 这三个命令构成了命令行导航的基石。

pwd (Print Working Directory)

此命令用于显示您当前所在的完整、绝对路径。当您在复杂的目录结构中感到迷失时,pwd 是您定位自身位置最可靠的工具。

1 | $ pwd |

ls (List)

ls 命令用于列出当前目录下的文件和子目录。它是您观察环境、获取信息的“眼睛”。ls 的强大之处在于其丰富的选项,可以组合使用以获得不同维度的信息。

ls -l(Long Format): 以长格式(详细信息)列出内容。1

2$ ls -l

-rw-r--r-- 1 prorise prorise 0 Sep 17 10:24 index.html输出解读(从左到右):

- 文件类型与权限: 第一个字符(

-代表文件,d代表目录)。后面九个字符代表所有者、所属组、其他人的读®写(w)执行(x)权限。 - 硬链接数: 指向此文件的硬链接数量。

- 所有者: 文件或目录的拥有者。

- 所属组: 文件或目录所属的用户组。

- 大小: 文件大小(默认为字节)。

- 最后修改时间: 文件内容的最后修改日期和时间。

- 名称: 文件或目录的名称。

- 文件类型与权限: 第一个字符(

ls -a(All): 显示所有文件,包括以.开头的隐藏文件(通常是配置文件)。ls -h(Human-readable): 必须与-l配合使用 (ls -lh),它会将文件大小以更易读的单位(如 K, M, G)显示。ls -t(Time): 按最后修改时间排序,最新的文件会显示在最前面。ls -r(Reverse): 反转当前的排序顺序。

常用组合: ls -alhtr 是一个非常实用的组合,它会以详细、易读的格式,列出所有文件(包括隐藏文件),并按时间从最旧到最新排序,让您能快速定位最近发生变化的文件。

cd (Change Directory)

cd 命令用于在目录之间切换。它有一些特殊的快捷方式,极大提升了导航效率。

cd <目录路径>: 切换到指定目录,如cd /var/log。cd .: 切换到当前目录(.代表当前目录),这在某些脚本场景中有用。cd ..: 切换到上一级(父)目录(..代表父目录)。cd ~或直接cd: 快速返回当前用户的家目录 (/home/<username>)。cd -: 切换到 上一次 所在的目录。这是一个非常高效的快捷方式,用于在两个目录间来回跳转。

6.2. 增删改查:touch, mkdir, rm, cp, mv

这是文件系统的基本“CRUD”(Create, Read, Update, Delete)操作在命令行中的体现。

touch <文件名>:

主要有两个功能:1. 如果文件不存在,则创建一个空的文本文件。 2. 如果文件已存在,则更新其访问和修改时间为当前时间。mkdir <目录名>:

创建一个新的目录。-p(parents): 这是一个极其有用的选项,允许您一次性创建多层嵌套的目录,即使父目录不存在也会被自动创建。例如:mkdir -p new_project/src/components。

rm <文件名>:

删除文件。-r(recursive): 递归删除。要删除一个目录及其内部所有内容,必须使用此选项。-f(force): 强制删除,忽略不存在的文件并且从不提示。

删库跑路警告: rm -rf / 是 Linux 中最危险的命令之一。rm -rf 会无提示地强制递归删除指定目录下的所有内容。在使用 rm -rf 时,请务必再三确认您所在的路径和要删除的目标,一旦执行,数据恢复将极其困难甚至不可能。

cp <源> <目标>:

复制文件或目录。-r(recursive): 复制目录时必须使用此选项,它会复制整个目录及其内容。示例:cp -r ~/projects/app1 /var/www/将app1整个目录复制到/var/www/下。

mv <源> <目标>:

移动或重命名文件/目录。mv命令有两个核心用途:- 移动: 如果“目标”是一个已存在的目录,

mv会将“源”移动到该目录下。mv server.js ./config/ - 重命名: 如果“目标”是一个不存在的文件名(且在同一目录下),

mv会将“源”重命名。mv server.js app.js

- 移动: 如果“目标”是一个已存在的目录,

6.3. 搜索利器 find

find 是一个功能极其强大的文件搜索工具,它通过遍历文件系统来根据指定的条件进行实时查找。基本语法为:find [起始路径] [表达式选项] [操作]

- 按名称查找 (

-name):

支持通配符*。-iname为不区分大小写的版本。find /home/your_username -name "*.js" - 按类型查找 (

-type):find . -type d(查找所有目录)find . -type f(查找所有普通文件) - 按大小查找 (

-size):+表示大于,-表示小于。单位:c(字节),k(KB),M(MB),G(GB)。find /var/log -type f -size +100M(查找/var/log目录下大于 100MB 的文件) - 按修改时间查找 (

-mtime):-n(n 天内修改过),+n(n 天前修改过)。find . -mtime -7(查找 7 天内被修改过的文件)

6.4 核心速查总结

| 分类 | 关键命令 | 核心描述 |

|---|---|---|

| 文件系统导航 | pwd | 显示当前工作目录的绝对路径,用于精确定位。 |

ls (及 -l, -a, -h, -t, -r 选项) | 列出目录内容。-l 提供详细信息,-a 显示隐藏文件,-h 使大小易读。是观察环境的主要工具。 | |

cd (及 . .. ~ - 特殊符号) | 切换目录。~ 用于快速返回家目录,- 用于在最近两个目录间快速跳转,极大提升效率。 | |

| 文件/目录管理 | touch <文件名> | 创建空文件或更新已存在文件的时间戳。 |

mkdir <目录名> (及 -p 选项) | 创建目录。-p 选项可以一次性创建多层嵌套目录,非常实用。 | |

rm <文件/目录> (及 -r, -f 选项) | 删除文件或目录。-r 用于递归删除目录,-f 用于强制删除。rm -rf 是高危操作,需谨慎使用。 | |

cp <源> <目标> (及 -r 选项) | 复制文件或目录。复制目录时必须使用 -r 选项。 | |

mv <源> <目标> | 移动或重命名文件/目录。其具体行为取决于“目标”是否存在。 | |

| 文件内容搜索 | find <路径> <表达式> | 实时、递归地在文件系统中按名称、类型、大小、修改时间等多种条件查找文件,是强大的搜索工具。 |

第七章:文本内容查看与处理:告别鼠标,拥抱键盘

摘要: 掌握了文件系统的结构与基本操作后,本章将带您深入文件的“内部世界”。作为开发者,我们日常打交道最多的就是纯文本文件——代码、配置、日志。本章将通过一个贯穿始终的实战场景,让您彻底掌握在命令行中高效查看、监控、比较文本内容的“内功心法”。我们将从最基础的 cat 命令出发,进阶到大文件,再到实时日志监控的利器 tail -f,并最终揭开 Linux 设计哲学中最精髓的部分——数据流 与 管道 的神秘面纱。完成本章,您将能在纯键盘环境中,完成过去依赖图形界面才能完成的文本处理任务,效率倍增。

在开始之前,让我们先创建一个专用的工作区并准备好本次实战所需的“素材”。请打开您的 WSL 终端,跟随我完成以下操作:

回到我们的项目根目录

1

2

3

4# 无论当前在哪,先回到家目录

cd ~

# 进入我们之前创建的项目文件夹

cd projects创建本章的演示目录并进入

1

2mkdir text-processing-demo

cd text-processing-demo现在,我们的工作起点是

~/projects/text-processing-demo。创建几个用于演示的文本文件

我们将创建三个文件:一个简短的配置文件config.v1.txt,一个内容稍有不同的config.v2.txt,以及一个模拟的、行数较多的日志文件app.log。1

2

3

4

5

6

7

8# 创建第一个配置文件

echo -e "SERVER_HOST=127.0.0.1\nDEBUG_MODE=true\nVERSION=1.0" > config.v1.txt

# 创建第二个配置文件,注意 DEBUG_MODE 和 VERSION 的值不同

echo -e "SERVER_HOST=127.0.0.1\nDEBUG_MODE=false\nVERSION=2.0" > config.v2.txt

# 创建一个有 200 行的模拟日志文件

for i in {1..200}; do echo "Line $i: Log entry message." >> app.log; done现在,使用

ls -l命令检查一下,您应该能看到这三个文件已经成功创建。我们所有的“兵器”都已备好,可以开始操练了!

7.1. 全文速览:cat 与 tac

cat (concatenate) 是我们最先接触的文本查看命令。它的核心功能是将一个或多个文件的内容,一次性地、不间断地 输出到屏幕上(标准输出)。

1 | # 查看第一个配置文件的内容 |

1

2

3

SERVER_HOST=127.0.0.1

DEBUG_MODE=true

VERSION=1.0

cat 非常适合用来快速查看那些内容简短、一屏幕就能显示完的文件。

而 tac 命令(cat 的反写)则刚好相反,它会 从最后一行开始,反向 输出文件的所有内容。

1 | # 反向查看第一个配置文件的内容 |

1

2

3

VERSION=1.0

DEBUG_MODE=true

SERVER_HOST=127.0.0.1

tac 在调试按时间顺序记录的日志文件时偶尔会用到,可以让你优先看到最新的日志条目。

cat 的局限性:现在,请试着用 cat 查看我们创建的 app.log 文件:

1 | cat app.log |

您会发现,终端屏幕被瞬间刷屏,您只能看到最后几行的内容,想看前面的内容只能费力地向上滚动鼠标滚轮。这暴露了 cat 的核心问题:它不适合查看大文件。

7.2. 分页阅读器 less:交互式浏览大文件的正确姿势

为了解决 cat 的问题,Linux 提供了更强大的分页阅读器 less。less 的核心优势在于它 不会一次性加载整个文件,而是只加载并显示当前屏幕所需的内容,因此打开大文件几乎是瞬时的,并且提供了丰富的交互式导航功能。

让我们用 less 打开 app.log:

1 | less app.log |

执行后,您会进入一个全屏的交互界面,底部会显示文件名。现在,请放下鼠标,尝试以下键盘操作:

- 基本导航:

- 使用 ↑ 和 ↓ 键,可以逐行上下滚动。

- 使用 PageUp 和 PageDown 键(或空格键),可以整页翻动。

- 快速跳转:

- 按下 g 键,会立刻跳转到文件的 第一行。

- 按下大写的 G 键,会立刻跳转到文件的 最后一行。

- 搜索:

- 按下 / 键,然后输入您想搜索的关键词(例如

Line 55),再按回车。所有匹配的行都会高亮显示。 - 按下 n 键,可以跳转到下一个匹配项。

- 按下大写的 N 键,可以跳转到上一个匹配项。

- 按下 / 键,然后输入您想搜索的关键词(例如

- 退出:

- 只需按下 q 键,即可退出

less界面,返回到您的终端提示符。

- 只需按下 q 键,即可退出

为什么不用 more?

您可能还会听到一个名为 more 的命令,它是 less 的前辈。more 只能向下翻页,不支持向上滚动和自由搜索,功能相对简陋。因此,在现代 Linux 系统中,我们应始终选择功能更强大的 less。 有一句流行的俏皮话可以帮助您记住:less is more (less 的功能比 more 更多)。

7.3. 日志监控神器:tail

tail 命令的字面意思是“尾巴”,它的主要功能是查看文件的末尾部分,这对于监控持续写入新内容的日志文件来说至关重要。

查看末尾 N 行:

默认情况下,tail会显示文件的最后 10 行。您也可以使用-n选项指定行数。1

2# 查看 app.log 的最后 5 行

tail -n 5 app.log1

2

3

4

5Line 196: Log entry message.

Line 197: Log entry message.

Line 198: Log entry message.

Line 199: Log entry message.

Line 200: Log entry message.实时监控 (

-f选项):

这是tail命令的“杀手级”功能。-f(follow) 选项会让tail命令保持运行,并 实时显示 追加到文件末尾的新内容。现在,让我们来亲身体验一下。请执行以下命令:

1

tail -f app.log

此时,您的终端会显示

app.log的最后几行,并且光标会停留在那里,程序不会退出。接下来,请不要关闭这个终端。右键点击 Windows Terminal 的标签栏,选择“拆分窗格”(或按

Alt+Shift+D),打开一个新的终端窗格。在新窗格中,同样进入~/projects/text-processing-demo目录,然后执行以下命令,向app.log文件追加一条新内容:1

2# 命令 要输出的文本内容 重定向指令 目标文件

echo "ALERT: A new event just happened!" >> app.log

当您在新窗格中按下回车的一瞬间,请立刻观察左边的旧窗格。您会神奇地发现,ALERT: A new event just happened! 这行新日志,已经 实时地、自动地 出现在了 tail -f 的输出中!

这个功能对于开发者调试程序、运维人员监控服务状态来说,是无可替代的核心技能。要停止 tail -f 的监控,只需在对应的窗格中按下 Ctrl + C。

7.4. 文件比较 diff:找出细微差异

diff 命令是开发者的另一把利器,它能逐行比较两个文本文件的差异,并精确地告诉您如何将第一个文件修改成第二个文件。

现在,我们来比较一下之前创建的两个配置文件:

1 | diff config.v1.txt config.v2.txt |

1

2

3

4

5

6

2,3c2,3

< DEBUG_MODE=true

< VERSION=1.0

---

> DEBUG_MODE=false

> VERSION=2.0

如何解读 diff 的输出:

2,3c2,3:这表示文件 1 的第 2 到 3 行 (2,3) 需要被 更改 (cfor change) 为文件 2 的第 2 到 3 行 (2,3)。< DEBUG_MODE=true和< VERSION=1.0:以<开头的行,代表它们是只存在于 第一个文件(config.v1.txt)中的内容。---:这是一个分隔符。> DEBUG_MODE=false和> VERSION=2.0:以>开头的行,代表它们是只存在于 第二个文件(config.v2.txt)中的内容。

diff 还会用 a (add) 表示需要添加的行,用 d (delete) 表示需要删除的行。在版本控制系统(如 Git)诞生之前,开发者们就是通过生成和应用 diff 产生的“补丁”文件来协作编码的。

7.5. 数据流与重定向:深入理解 > (覆盖), >> (追加), | (管道)

这是 Linux 命令行最精髓、最强大的部分。理解了它,您就从“执行单个命令”的层次,跃升到了“编排命令流”的全新维度。

核心概念:三个标准数据流

在 Linux 中,每个程序运行时都会默认打开三个数据流(Streams):

- 标准输入 (stdin, 文件描述符 0): 程序默认从这里读取数据,通常连接到我们的键盘。

- 标准输出 (stdout, 文件描述符 1): 程序默认将 正常的、成功的 结果输出到这里,通常连接到我们的终端屏幕。

- 标准错误 (stderr, 文件描述符 2): 程序默认将 错误信息 输出到这里,通常也连接到我们的终端屏幕。

输出重定向:> 和 >>

重定向就是改变数据流的默认目的地。

>(覆盖写入): 将命令的标准输出 (stdout) 发送到一个文件,如果文件已存在,其 原有内容会被完全覆盖。1

2

3

4

5

6

7

8

9

10

11# 将 ls -l 的结果写入 file_list.txt

ls -l > file_list.txt

# 查看文件内容

cat file_list.txt

# 现在用 pwd 的结果再次写入,会覆盖掉之前 ls 的结果

pwd > file_list.txt

# 再次查看,内容已经变了

cat file_list.txt>>(追加写入): 将命令的标准输出 (stdout) 发送到一个文件,如果文件已存在,新内容会 追加到文件的末尾,原有内容保持不变。1

2

3

4

5

6

7

8# 先用 ls -l 的结果覆盖写入

ls -l > file_list.txt

# 然后用 pwd 的结果追加写入

pwd >> file_list.txt

# 再次查看,会发现 pwd 的结果被添加在了 ls 结果的后面

cat file_list.txt2>&1(错误流合并): 这是一个高级但非常重要的用法。它表示将标准错误流(2)重定向(>)到与标准输出流(1)相同的地方(&1)。这通常用于将正常输出和错误信息都记录到同一个日志文件中。

管道 |:命令的流水线

如果说重定向是改变水流的方向,那管道 (|) 就是将一个命令的出水口,直接连接到另一个命令的入水口。 它将前一个命令的 标准输出 (stdout),作为后一个命令的 标准输入 (stdin),形成一条强大的处理流水线。

实战体验管道的威力:

- 问题:

app.log文件有 200 行,我想找到包含 “Line 15” 的那一行,但我不想用less手动搜索。 - 思路: 我们可以让

cat app.log把全部内容输出,然后用管道|把这些内容“喂”给一个专门用于文本搜索的命令grep。 - 执行:几乎在瞬间,终端就精确地输出了所有包含 “Line 15” 的行,过滤掉了其他 199 行无关信息。

1

cat app.log | grep "Line 15"

再来一个例子:

- 问题: 我想查看

/etc目录下有多少个文件和目录,但ls /etc的输出太长了,会刷屏。 - 思路: 我们可以把

ls -1 /etc(-1选项让每个条目占一行)的输出结果通过管道“喂”给wc -l命令,wc -l的作用是统计输入的行数。 - 执行:您会直接得到一个数字,这就是

1

ls -1 /etc | wc -l

/etc目录下的条目总数,整个过程没有任何刷屏。

通过管道,我们可以将多个小而精的命令组合起来,完成极其复杂的任务。这正是 Linux “组合小程序,完成大任务”设计哲学的完美体现。

第八章:文本处理三巨头:grep, sed, 与 awk

摘要: 欢迎来到命令行世界的“内功心法”篇。本章,我们将从简单的文件查看,跃迁至真正的数据处理与驾驭。我们将系统性地解构 Linux 环境下最富传奇色彩的三大文本处理工具:grep 用于信息过滤,sed 用于流式编辑,而 awk 则用于数据提取与报告生成。我们学习的将不只是命令,更是一种全新的思维方式——将数据视为可以被精确切割、转换和分析的“数据流”。通过一系列对真实配置文件和日志文件的实战演练,您将逐一精通每个工具,并最终在“组合拳”环节中,将它们串联成强大的处理流水线,完成一次真实世界的日志分析任务。本章是您从一名命令行“使用者”,蜕变为一名命令行“大师”的关键之桥。

8.1. 准备工作:创建我们的“数字靶场”

工欲善其事,必先利其器。在学习如何使用这些强大的“文本兵器”之前,我们需要一个合适的训练场。我们将专门创建一个包含真实世界场景的“实验靶场”,这将是我们贯穿本章所有操作的素材。

导航至项目根目录

1

cd ~/projects

创建本章专属的工作目录

1

2mkdir text-processing-trinity

cd text-processing-trinity现在,我们所有的操作都将在

~/projects/text-processing-trinity目录下进行。创建素材一:应用配置文件 (

app.conf)

我们将使用一种名为 “Here Document” 的方法,快速创建一个多行的配置文件。这种方法远比用echo拼接要优雅。1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18cat << EOF > app.conf

# General Application Settings

app_name = "ProRise Web App"

version = 1.0.5

debug = true

[database]

# Database connection details

host = localhost

port = 3306

user = admin

password = "complex_password_123"

[server]

listen_address = 0.0.0.0

listen_port = 8080

ssl_enabled = false

EOF这条命令的含义是:将从

<< EOF开始,到下一个EOF结束的所有内容,都当作cat命令的输入,并将其重定向 (>) 到app.conf文件中。创建素材二:Nginx 访问日志 (

access.log)

同理,我们创建一个模拟的、但格式非常规范的 Nginx 日志文件。1

2

3

4

5

6

7

8

9

10

11

12

13

14cat << EOF > access.log

192.168.1.10 - - [17/Sep/2025:10:00:01 +0000] "GET /index.html HTTP/1.1" 200 1543 "-" "Mozilla/5.0 (Windows NT 10.0)"

10.0.0.5 - - [17/Sep/2025:10:00:02 +0000] "GET /styles/main.css HTTP/1.1" 200 5678 "-" "Mozilla/5.0 (Windows NT 10.0)"

192.168.1.10 - - [17/Sep/2025:10:00:03 +0000] "POST /api/login HTTP/1.1" 200 312 "-" "Mozilla/5.0 (Windows NT 10.0)"

10.0.0.5 - - [17/Sep/2025:10:00:04 +0000] "GET /images/logo.png HTTP/1.1" 200 12045 "-" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7)"

203.0.113.42 - - [17/Sep/2025:10:01:10 +0000] "GET /products/item123 HTTP/1.1" 404 150 "-" "Mozilla/5.0 (iPhone; CPU iPhone OS 17_0 like Mac OS X)"

192.168.1.10 - - [17/Sep/2025:10:01:15 +0000] "GET /api/user/profile HTTP/1.1" 200 850 "-" "curl/7.81.0"

10.0.0.5 - - [17/Sep/2025:10:02:01 +0000] "POST /api/submit-form HTTP/1.1" 200 450 "-" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7)"

192.168.1.10 - - [17/Sep/2025:10:02:05 +0000] "GET /logout HTTP/1.1" 302 0 "-" "Mozilla/5.0 (Windows NT 10.0)"

10.0.0.5 - - [17/Sep/2025:10:03:00 +0000] "GET /favicon.ico HTTP/1.1" 200 1500 "-" "Mozilla/5.0 (Windows NT 10.0)"

78.141.223.102 - - [17/Sep/2025:10:03:30 +0000] "GET /admin/panel HTTP/1.1" 403 150 "-" "Mozilla/5.0 (X11; Linux x86_64)"

10.0.0.5 - - [17/Sep/2025:10:04:00 +0000] "GET /about.html HTTP/1.1" 200 2345 "-" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7)"

192.168.1.10 - - [17/Sep/2025:10:05:00 +0000] "POST /api/v2/data HTTP/1.1" 500 50 "-" "python-requests/2.28.1"

EOF验证靶场

使用ls -l检查文件是否创建成功,并用cat快速预览一下它们的内容,确保一切就绪。1

2ls -l

cat app.conf至此,我们的靶场已经建好,弹药已经上膛。现在,让我们请出第一位巨头。

8.2. 第一巨头 grep:大海捞针的“信息声纳”

8.2.1 核心定位

grep (Global regular expression print) 是三大工具中最直接、最常用的一个。请将它想象成一个功能极其强大的“信息声纳”或“过滤器”。你给它一个模式(声纳要探测的目标),再给它一片数据海洋(文件或数据流),它就能精准地将包含这个模式的所有信息行(声纳的回波)捞出来给你。

8.2.2 基础过滤

grep 最基础的用法就是 grep "要查找的字符串" 文件名。

假设我们想在 access.log 中找到所有 POST 请求的记录。

1 | grep "POST" access.log |

1

2

3

192.168.1.10 - - [17/Sep/2025:10:00:03 +0000] "POST /api/login HTTP/1.1" 200 312 "-" "Mozilla/5.0 (Windows NT 10.0)"

10.0.0.5 - - [17/Sep/2025:10:02:01 +0000] "POST /api/submit-form HTTP/1.1" 200 450 "-" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7)"

192.168.1.10 - - [17/Sep/2025:10:05:00 +0000] "POST /api/v2/data HTTP/1.1" 500 50 "-" "python-requests/2.28.1"

grep 逐行读取了 access.log,并只打印了那些包含了 “POST” 字符串的行。简单、高效、精确。

8.2.3 核心选项精讲

grep 的强大之处在于其丰富的选项,它们能让你的过滤行为更加精细化。

-i(ignore-case): 忽略大小写

假设我们想查找所有来自Macintosh系统的访问记录,但我们不确定日志里写的是Macintosh还是macintosh。1

grep -i "macintosh" access.log

1

2

310.0.0.5 - - [17/Sep/2025:10:00:04 +0000] "GET /images/logo.png HTTP/1.1" 200 12045 "-" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7)"

10.0.0.5 - - [17/Sep/2025:10:02:01 +0000] "POST /api/submit-form HTTP/1.1" 200 450 "-" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7)"

10.0.0.5 - - [17/Sep/2025:10:04:00 +0000] "GET /about.html HTTP/1.1" 200 2345 "-" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7)"-v(invert-match): 反向匹配

这是grep最有用的选项之一。它会打印出 不包含 指定模式的行。假设我们想查看所有 非成功(状态码不是 200)的请求。技巧: 我们搜索的是

" 200 "而不是"200",在数字两边加上空格,是为了避免错误匹配到像1200这样的字节数。1

grep -v " 200 " access.log

1

2

3

4203.0.113.42 - - [17/Sep/2025:10:01:10 +0000] "GET /products/item123 HTTP/1.1" 404 150 "-" "Mozilla/5.0 (iPhone; CPU iPhone OS 17_0 like Mac OS X)"

192.168.1.10 - - [17/Sep/2025:10:02:05 +0000] "GET /logout HTTP/1.1" 302 0 "-" "Mozilla/5.0 (Windows NT 10.0)"

78.141.223.102 - - [17/Sep/2025:10:03:30 +0000] "GET /admin/panel HTTP/1.1" 403 150 "-" "Mozilla/5.0 (X11; Linux x86_64)"

192.168.1.10 - - [17/Sep/2025:10:05:00 +0000] "POST /api/v2/data HTTP/1.1" 500 50 "-" "python-requests/2.28.1"-n(line-number): 显示行号

在排查问题时,知道匹配项在原始文件中的具体行数非常重要。1

grep -n "404" access.log

1

5:203.0.113.42 - - [17/Sep/2025:10:01:10 +0000] "GET /products/item123 HTTP/1.1" 404 150 "-" "Mozilla/5.0 (iPhone; CPU iPhone OS 17_0 like Mac OS X)"

输出结果开头的

5:清晰地告诉我们,这条 404 错误发生在日志文件的第 5 行。-c(count): 统计匹配行数

如果你只关心有多少行匹配,而不需要看具体内容,-c选项非常高效。例如,统计 IP192.168.1.10发起了多少次请求。1

grep -c "192.168.1.10" access.log

1

5

我们立刻得到了答案,无需手动去数。

在排查程序故障时,仅仅看到出错的那一行日志往往是不够的。我们通常需要知道错误发生前发生了什么,错误发生后又触发了什么。grep 的上下文掌控选项正是为此而生,它能把“案发现场”周边的信息一并呈现给你。

假设我们定位到了那条返回 500 服务器错误的日志,这是问题的核心,但我们想看看这个请求前后,同一个 IP 还做了些什么。

-C(Context): 显示匹配行 前 后 N 行的内容

我们以500错误为核心,查看它 前后各 2 行 的日志。1

grep -C 2 " 500 " accaess.log

1

210.0.0.5 - - [17/Sep/2025:10:04:00 +0000] "GET /about.html HTTP/1.1" 200 2345 "-" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7)"

192.168.1.10 - - [17/Sep/2025:10:05:00 +0000] "POST /api/v2/data HTTP/1.1" 500 50 "-" "python-requests/2.28.1"注意: 在我们的示例文件中,500 错误是最后一行,所以它只能显示出前面的日志。如果它在文件中间,则会同时显示前后内容。

-A(After): 显示匹配行以及后 N 行的内容

查看500错误 之后 的 2 行(在我们的例子中,因为是最后一行,所以他只会输出自己)。1

grep -A 2 " 500 " access.log

-B(Before): 显示匹配行以及前 N 行的内容

查看500错误 之前 的 2 行。1

grep -B 2 " 500 " access.log

1

2

378.141.223.102 - - [17/Sep/2025:10:03:30 +0000] "GET /admin/panel HTTP/1.1" 403 150 "-" "Mozilla/5.0 (X11; Linux x86_64)"

10.0.0.5 - - [17/Sep/2025:10:04:00 +0000] "GET /about.html HTTP/1.1" 200 2345 "-" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7)"

192.168.1.10 - - [17/Sep/2025:10:05:00 +0000] "POST /api/v2/data HTTP/1.1" 500 50 "-" "python-requests/2.28.1"这三个选项在分析有时序关系的日志文件时,价值千金。

8.2.4 范围搜索

到目前为止,我们都只在单个文件中搜索。但在真实开发中,我们往往需要在整个项目成百上千个文件中,查找某个函数或变量的所有引用。这正是 -r 选项的用武之地。

-r(Recursive): 递归搜索-r选项会从你指定的目录开始,递归地 搜索该目录下以及所有子目录下的全部文件。让我们来模拟一个真实场景。首先,创建一个项目目录结构:

1

2

3

4

5

6

7

8

9# 创建项目结构

mkdir my_web_project

mkdir my_web_project/js

mkdir my_web_project/css

# 在不同文件中写入包含 "color" 的内容

echo ".main { color: #333; }" > my_web_project/css/style.css

echo "let favorite_color = 'blue';" > my_web_project/js/main.js

echo "This is a colorful day" > my_web_project/README.md现在,假设我们想在

my_web_project这个项目中,找到所有提到color的地方,但我们不确定大小写。1

grep -ir "color" my_web_project/

1

2

3my_web_project/README.md:This is a colorful day

my_web_project/js/main.js:let favorite_color = 'blue';

my_web_project/css/style.css:.main { color: #333; }grep像一个勤劳的机器人,瞬间扫描了整个项目,并清晰地告诉我们:在哪个文件的哪一行,找到了匹配的内容。这几乎是每个程序员每天都会用到的核心操作。

8.2.5 能力升华:为 grep 装上“精确瞄准镜”——正则表达式入门

如果说普通 grep 是在用“渔网”捞鱼,那么学会了正则表达式的 grep 就是在用“精确制导鱼雷”。正则表达式(Regular Expression, or Regex)是一种描述文本模式的强大语言,它是解锁三巨头全部威力的终极钥匙。

我们将使用 -E (Extended Regex) 选项来开启 grep 的扩展正则引擎,它的语法更现代、更易读。

^(Caret): 匹配行的开头

假设我们只想找那些由 IP10.0.0.5发起的请求记录。如果只搜"10.0.0.5",可能会匹配到其他地方。但我们知道,IP 地址一定在行首。1

grep -E "^10.0.0.5" access.log

1

2

3

4

510.0.0.5 - - [17/Sep/2025:10:00:02 +0000] "GET /styles/main.css HTTP/1.1" 200 5678 "-" "Mozilla/5.0 (Windows NT 10.0)"

10.0.0.5 - - [17/Sep/2025:10:00:04 +0000] "GET /images/logo.png HTTP/1.1" 200 12045 "-" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7)"

10.0.0.5 - - [17/Sep/2025:10:02:01 +0000] "POST /api/submit-form HTTP/1.1" 200 450 "-" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7)"

10.0.0.5 - - [17/Sep/2025:10:03:00 +0000] "GET /favicon.ico HTTP/1.1" 200 1500 "-" "Mozilla/5.0 (Windows NT 10.0)"

10.0.0.5 - - [17/Sep/2025:10:04:00 +0000] "GET /about.html HTTP/1.1" 200 2345 "-" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7)"$(Dollar): 匹配行的结尾

假设我们想找到那些由特定客户端发起的请求,比如curl或python-requests,我们知道这些信息通常在日志行的末尾。因为

"在 Shell 中有特殊含义,所以我们在它前面加一个反斜杠\来“转义”,告诉 Shell 把它当作一个普通字符。1

2

3# 查找以 ") " 结尾的行可能会误伤,但我们可以找以特定字符串结尾的

# 我们找以 curl/7.81.0 " 结尾的行

grep -E "curl/7.81.0\"$" access.log1

192.168.1.10 - - [17/Sep/2025:10:01:15 +0000] "GET /api/user/profile HTTP/1.1" 200 850 "-" "curl/7.81.0"

|(Pipe/OR): 匹配多个模式之一

如果我们想一次性找出所有404或403的错误日志。1

grep -E " 404 | 403 " access.log

1

2203.0.113.42 - - [17/Sep/2025:10:01:10 +0000] "GET /products/item123 HTTP/1.1" 404 150 "-" "Mozilla/5.0 (iPhone; CPU iPhone OS 17_0 like Mac OS X)"

78.141.223.102 - - [17/Sep/2025:10:03:30 +0000] "GET /admin/panel HTTP/1.1" 403 150 "-" "Mozilla/5.0 (X11; Linux x86_64)".(Dot) 和*(Asterisk): 匹配任意字符.代表 任意单个字符,而*代表它前面的那个字符可以出现 0 次或多次。它们组合起来.*就意味着“任意数量的任意字符”,这是一个强大的“万能牌”。假设我们想找到所有访问

/api/目录下的请求,但不关心/api/后面具体是什么。1

grep -E " GET /api/.* HTTP " access.log

这个模式的含义是:查找包含 “GET /api/”,后面跟着 任意数量的任意字符 (

.*),直到遇见 " HTTP" 的行。1

2

3

4192.168.1.10 - - [17/Sep/2025:10:00:03 +0000] "POST /api/login HTTP/1.1" 200 312 "-" "Mozilla/5.0 (Windows NT 10.0)"

192.168.1.10 - - [17/Sep/2025:10:01:15 +0000] "GET /api/user/profile HTTP/1.1" 200 850 "-" "curl/7.81.0"

10.0.0.5 - - [17/Sep/2025:10:02:01 +0000] "POST /api/submit-form HTTP/1.1" 200 450 "-" "Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7)"

192.168.1.10 - - [17/Sep/2025:10:05:00 +0000] "POST /api/v2/data HTTP/1.1" 500 50 "-" "python-requests/2.28.1"

grep 的学习到此告一段落。我们已经从一个简单的过滤器,升级到了一个能理解上下文、能跨文件搜索、能使用正则表达式进行精确打击的强大工具。

8.3. 第二巨头 sed:精准制导的“流編輯器”

8.3.1 核心定位

sed (Stream Editor) 的名字已经揭示了它的本质。请把它想象成一条 文本加工流水线 上的一个自动化机器人。

- 流 (Stream): 文本数据(通常是文件的内容)像流水一样,一行一行地从它面前经过。

- 编辑器 (Editor):

sed机器人手持一套预设指令,当某一行文本流过,如果符合指令中的条件,它就会对这一行进行修改(比如替换、删除、添加文字),然后将修改后的行继续传送到流水线的下一站(通常是你的屏幕)。

最关键的是,这个过程是 非交互式 的。你事先告诉机器人所有规则,然后它就自动处理整个文件,无需你中途干预。这使得 sed 成为自动化脚本中修改配置文件的王者。

8.3.2 核心武器:替换命令详解

sed 有很多指令,但 95% 的日常使用场景都依赖于它最核心、最强大的武器——s (substitute) 替换命令。它的语法结构非常清晰:s/模式/替换内容/标志。

让我们逐一拆解:

s: 命令本身,代表“替换”。模式 (pattern): 你想查找的内容。这里同样可以使用我们刚刚在grep中学到的 正则表达式!替换内容 (replacement): 你想把匹配到的内容换成什么。标志 (flags): 用来控制替换行为的额外选项。

实战演练:

首先,让我们用 cat 预览一下我们的配置文件 app.conf,以便对比。

1 | cat app.conf |

现在,假设我们想把配置文件中的 localhost 临时换成 127.0.0.1 来测试一下。

1 | sed 's/localhost/127.0.0.1/' app.conf |

1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

# General Application Settings

app_name = "ProRise Web App"

version = 1.0.5

debug = true

[database]

# Database connection details

host = 127.0.0.1

port = 3306

user = admin

password = "complex_password_123"

[server]

listen_address = 0.0.0.0

listen_port = 8080

ssl_enabled = false

看!host 那一行的 localhost 已经被成功替换。但此时,请检查一下原始文件:

1 | cat app.conf |

你会发现,app.conf 文件本身根本没有变化!这正是 sed 默认的安全特性:它只是将 修改后的结果 打印到标准输出(你的屏幕),并不会触碰原文件。

8.3.3 替换标志 (Flags) 的威力

g(global): 全局替换

默认情况下,sed的s命令只会替换 每行中第一个 匹配到的内容。让我们创建一个例子来证明这一点:1

echo "hello world, hello linux" | sed 's/hello/hi/'

你会看到输出是 hi world, hello linux,只有第一个 hello 被替换了。

如果想替换一行中所有匹配项,就必须使用 `g` 标志。

1

echo "hello world, hello linux" | sed 's/hello/hi/g'

这次,输出就是 hi world, hi linux。

i(ignore-case): 忽略大小写

假设我们要把app.conf里的user = admin换成user = root,但我们不确定配置文件里写的是user还是USER。1

sed 's/user = admin/user = root/i' app.conf

8.3.4 实战演练:批量修改配置文件

现在我们来执行一个更真实的任务:将 app.conf 中的数据库端口从 3306 修改为 3307。

1 | sed 's/port = 3306/port = 3307/' app.conf |

再来一个高级点的:我们想把 debug = true 这一行整个 注释掉。我们可以匹配 debug = true,然后把它替换成 # debug = true。这里有一个神奇的特殊字符 &,它在替换内容中代表 整个被匹配到的模式。

1 | sed 's/debug = true/# &/' app.conf |

这个命令的含义是:找到 debug = true,把它替换成一个 # 号、一个空格,以及 它自身 (&)。

1

# debug = true

8.3.5 高危操作与安全实践:原地编辑 -i

每次都只是在屏幕上看到结果,如果我真的想修改文件本身呢?这就是 -i (in-place) 选项登场的时刻。

-i 选项会让 sed 直接修改原文件。这是一个非常强大但同样危险的操作,因为它没有“撤销”按钮!

让我们用它来将端口号 真正地 修改掉:

1 | sed -i 's/port = 3306/port = 3307/' app.conf |

这一次,你会发现 app.conf 文件中的端口号 已经被永久修改 为 3307 了。

专业人士的安全操作方法:

直接使用 -i 风险太高。sed 提供了一个更安全的“原地编辑”模式:在 -i 后面跟一个后缀名,比如 .bak。

1 | sed -i.bak 's/listen_port = 8080/listen_port = 9000/' app.conf |

执行这条命令后,sed 会做两件事:

- 创建一个名为

app.conf.bak的文件,它是 修改前 的原始文件备份。 - 将 修改后 的内容写入原始的

app.conf文件。

现在,让我们用 ls 和 cat 来验证一下:

1 | ls |

这才是使用 -i 选项的 最佳实践。如果修改出了问题,你随时可以用备份文件 app.conf.bak 来恢复。

sed 的学习核心是掌握 s 命令和安全的 -i.bak 操作。它是在自动化脚本中进行“无人值守”式文本修改的不二之选。

8.4. 第三巨头 awk:数据挖掘的“报表生成器”

8.4.1 核心定位

如果说 grep 是“过滤器”,sed 是“编辑器”,那么 awk 就是“数据分析师”。

请牢牢记住这个比喻:awk 就是命令行的 Excel。

- Excel 把数据整理成 行 和 列。

awk也是。 - Excel 可以对某一 列 进行求和、计算平均值。

awk也可以。 - Excel 可以根据某一 列 的条件,筛选出特定的 行。

awk也可以。 - Excel 可以生成格式化的 报表。

awk更可以。

一旦你用“处理电子表格”的思维来理解 awk,它所有的古怪语法都会瞬间变得清晰起来。

8.4.2 核心概念:记录 (Records) 与字段 (Fields)

awk 的世界里,只有两个核心概念:

- 记录 (Record): 默认情况下,

awk将文本中的 每一行 视为一条记录。这就像 Excel 中的“一行”。 - 字段 (Field):

awk会自动将每条记录(每一行),按 分隔符(默认为空格或 Tab)切割成多个部分,每个部分就是一个字段。这就像 Excel 中的“一列”。

为了操作这些字段,awk 提供了极其重要的 内置变量:

$0: 代表 整条记录(整行内容)。$1,$2,$3…: 分别代表第 1、第 2、第 3 个字段。NF(Number of Fields): 代表 当前记录 拥有的字段总数。NR(Number of Records): 代表awk到目前为止已经处理过的记录总数,也就是 当前行号。

让我们用 access.log 的第一行来做个“人工 awk”分析:192.168.1.10 - - [17/Sep/2025:10:00:01 +0000] "GET /index.html HTTP/1.1" 200 1543 "-" "Mozilla/5.0 (Windows NT 10.0)"

$1是192.168.1.10(IP 地址)$2是-$3是-$4是[17/Sep/2025:10:00:01$7是/index.html(请求的路径)$9是200(状态码)$10是1543(返回的字节数)

8.4.3 awk 的“语法骨架”:PATTERN { ACTION }

awk 的所有操作都遵循这个简单的“语法骨架”。它的工作逻辑是:

对于每一行,awk 都会判断 PATTERN (模式) 是否成立。如果成立,就执行 { ACTION } (动作) 里的命令。

PATTERN: 可以是一个正则表达式,也可以是一个条件判断语句(比如$9 == 404)。如果省略PATTERN,则对 所有行 都执行ACTION。{ ACTION }: 一系列由花括号包裹的指令,最常用的就是print。如果省略ACTION,则默认执行print $0(打印整行)。

实战演练:

无

PATTERN,对所有行执行ACTION: 打印日志中每条记录的 IP 地址 ($1) 和状态码 ($9)。1

awk '{ print $1, $ 9 }' access.log

1

2

3

4

5

6192.168.1.10 200

10.0.0.5 200

192.168.1.10 200

10.0.0.5 200

203.0.113.42 404

...有

PATTERN,对匹配行执行ACTION: 从access.log中,提取所有状态码为404的记录,并只打印其请求的 IP 地址 ($1) 和 访问的 URL ($7)。注意: 在

awk的条件判断中,字符串需要用双引号"包起来。1

awk '$9 == "404" { print "Client IP:", $ 1, "tried to access URL:", $7 }' access.log

1

Client IP: 203.0.113.42 tried to access URL: /products/item123

这个操作如果用

grep和其他工具组合会非常复杂,但awk一行就搞定了,因为它天生就是为处理“列”而生的。

8.4.4 结构化处理:BEGIN 与 END 模块

awk 还有两个特殊的 PATTERN,它们让 awk 真正成为了一个报表生成工具:

BEGIN { ... }: 这里面的ACTION会在awk处理任何一行文本之前 执行。它只执行一次。通常用来打印报表头,或者初始化变量。END { ... }: 这里面的ACTION会在awk处理完所有行文本之后 执行。它也只执行一次。通常用来进行最终的计算,并打印报表总结或脚注。

实战演练:计算日志文件中所有请求的总字节数和平均大小

1 | awk 'BEGIN { print "==== = Traffic Analysis Report ==== ="; sum = 0 } { sum += $10 } |

1

2

3

==== = Traffic Analysis Report ==== =

Total Bytes Transferred: 26424 bytes

Average Request Size: 2202.00 bytes

让我们分解这条看似复杂的命令:

BEGIN { ... }: 在开始前,先打印一个报表头,并初始化一个我们自己定义的变量sum为 0。{ sum += $10 }: 这是 核心处理逻辑。它没有PATTERN,所以对 每一行 都会执行。sum += $10的意思是,将当前行的第 10 个字段(字节数)累加到sum变量中。END { ... }: 在处理完所有行后,sum变量里已经存了总字节数。我们用printf(一个格式化打印命令) 来输出最终结果,包括用总字节数sum除以总行数NR得到的平均值。

看到这个结果,您是否感受到了 awk 的威力?我们没有使用任何外部工具,仅凭 awk 自身,就完成了一次真正的数据统计和报表生成。

8.5. 实战:三巨头组合拳,分析 Web 日志 Top 10 IP

任务目标

这是运维和数据分析领域一个最经典、最真实的任务:从成百上千行的 access.log 文件中,分析出访问我们网站最频繁的 Top 10 IP 地址,并统计出它们的具体访问次数。

这个问题,如果让你用 Python 或 Java 来写,可能需要几十行代码,包括读取文件、切分字符串、用哈希表计数、排序等等。但在命令行世界,我们只需要一条由管道连接起来的命令流水线。

这就是那条传说中的命令:

1 | cat access.log | awk '{print $1}' | sort | uniq -c | sort -nr | head -n 10 |

第一次看到它,可能会觉得像一段神秘的咒语。但现在,您已经掌握了大部分“法术”的原理。我们将把这条流水线 一步一步地拆解,像观察一个精密的机械装置一样,看数据流是如何在其中被一步步打磨、加工,最终变成我们想要的报告。

流水线步骤详解

第一步:cat access.log - 准备原始数据流

这一步很简单,我们用 cat 命令将 access.log 的全部内容不做任何修改,完整地输出,作为整个流水线的源头。

1 | cat access.log |

第二步:| awk '{print $1}' - 提取目标列 (awk 上场)

原始数据太庞杂,我们只关心 IP 地址。于是,数据流进入了第一个加工站——awk。我们使用 awk 强大的列处理能力,只打印出每一行的第一个字段 ($1),也就是 IP 地址。

1 | cat access.log | awk '{print $1}' |

数据变化: 数据流从完整的日志行,被精炼成了只包含 IP 地址的列表。

第三步:| sort - 排序,为计数做准备

为了统计每个 IP 出现了多少次,我们需要先让所有相同的 IP 地址“排在一起”。sort 命令就是负责这个任务的。它会按字母(和数字)顺序对输入的内容进行排序。

1 | cat access.log | awk '{print $1}' | sort |

数据变化: IP 列表变得井然有序,所有相同的 IP 都聚集在了一起。

第四步:| uniq -c - 去重与计数

现在数据已经排好队,轮到 uniq (unique) 命令登场了。uniq 的作用是去除重复的 连续行(这就是为什么前面必须先 sort)。而 -c (count) 选项则是一个“超级加强”,它在去重的同时,还会在每行前面加上该行重复出现的次数。

1 | cat access.log | awk '{print $1}' | sort | uniq -c |

数据变化: 数据流从一个长长的 IP 列表,变成了“次数 + IP”的统计报告。我们的目标已经接近完成了!

第五步:| sort -nr - 按访问次数排序

我们想知道谁是 Top 10,所以需要按访问次数从高到低排序。这里我们再次调用 sort 命令,但加了两个强大的选项:

-n(numeric-sort): 告诉sort按照 数字 大小来排序,而不是按文字顺序(否则10会排在2的前面)。-r(reverse-sort): 将排序结果 反转,实现从大到小的“降序”排列。

1 | cat access.log | awk '{print $1}' | sort | uniq -c | sort -nr |

数据变化: 统计报告已经按访问量从高到低完美排序。

第六步:| head -n 10 - 提取最终结果

万事俱备,只欠东风。我们只需要这个排序后列表的“头”几名。head 命令就是做这个的。-n 10 告诉它,我们只需要输出前面 10 行。

1 | cat access.log | awk '{print $1}' | sort | uniq -c | sort -nr | head -n 10 |

任务完成! 我们通过一条流水线,清晰、高效、优雅地解决了问题。这个过程完美地诠释了 Unix 哲学的精髓:每个程序只做一件事并做好,将它们组合起来,就能完成任何复杂的任务。

8.6. 本章核心速查总结

| 工具 | 核心定位 | 常用命令/语法 | 核心选项/变量 | 典型应用场景 |

|---|---|---|---|---|

grep | 文本过滤器 (大海捞针) | grep "pattern" file | -i: 忽略大小写-v: 反向匹配-r: 递归搜索-E: 扩展正则-C: 上下文 | 在日志中查找错误信息 在代码库中搜索函数引用 过滤出不符合条件的行 |

sed | 流编辑器 (批量修改) | sed 's/old/new/g' file | -i: 原地编辑-i.bak: 编辑并备份d: 删除行&: 引用匹配内容 | 批量修改配置文件 自动化脚本中替换变量 删除文件中的注释行或空行 |

awk | 报表生成器 (列处理大师) | awk 'PATTERN {ACTION}' file | $0, $1, $2...: 字段NF: 字段总数NR: 行号-F: 指定分隔符BEGIN/END | 提取日志文件的特定列 对结构化数据进行计算与统计 生成格式化的文本报告 |

第九章:深入理解 Linux 权限:从基础到 WSL 实战

摘要: 在本章中,我们将着手解决您在使用 WSL 时遇到的第一个,也是最常见的“拦路虎”——Permission denied。我们将从根本的思维模式入手,理解 Linux 与 Windows 在权限设计上的核心差异。随后,我们会系统学习 sudo, ls -l, chmod, chown 这“四大金刚”,并通过解决一系列真实开发场景中的问题(如脚本执行、SSH 密钥配置、Git 工作流冲突、Docker 卷挂载等),将这些命令内化为您的肌肉记忆。

本章学习地图: 我们将遵循一个由浅入深的路径:

- 首先,建立正确的安全理念,这是理解一切操作的前提。

- 接着,掌握最核心的权限查看与管理命令。

- 然后,将这些命令应用于日常开发工作流的实际问题中。

- 最后,攻克 Docker 和 WSL 环境特有的高级权限难题。

9.1. 根本理念:Linux 的“最小权限”安全模型

在我们正式敲下第一个关于权限的命令之前,我想先和你聊聊一个更重要的东西:思想的转变。如果不理解 Linux 在“安全”这件事上的底层设计逻辑,我们后续的所有操作都会感觉“别扭”和“不解”。

痛点背景:

回想一下我们在 Windows 上的习惯:当一个程序安装失败,或者修改某个系统文件(比如 C:\Windows\System32\drivers\etc\hosts)保存不了时,我们的第一反应是什么?大概率是找到程序图标,右键点击 -\> “以管理员身份运行”。我们习惯于在遇到阻碍时,通过提升整个程序的权限来“一劳永逸”地解决问题。

这种模式的潜在风险是:一旦这个拥有了管理员权限的程序本身出现漏洞,或者我们不小心在其中执行了高风险操作,那么整个系统都将面临威胁。

解决方案:

Linux 则采用了完全不同的哲学——最小权限原则。

这个原则的核心思想非常简单:默认情况下,任何程序和用户,都只应该拥有完成其任务所必需的最小权限集合。

你,作为登录 WSL 的普通用户(比如 prorise),绝大部分时间里,你的活动范围都被严格限制在自己的“家”里,也就是你的主目录 (/home/prorise,通常简写为 ~)。你在这里可以随意创建、修改、删除文件。但一旦你想对系统的其他部分“动手术”,比如安装软件(会写入 /usr/bin)、修改系统配置(会修改 /etc 目录下的文件),Linux 的安全机制就会立刻站出来,对你说:“不行,你没有这个权限。”

这并非“不方便”,而是一种严谨的保护机制。现在,让我们亲手感受一下这堵“安全之墙”。

动手操作:体验权限壁垒

让我们尝试模拟在 Windows 下修改 hosts 文件的行为。在 Linux 中,对应的文件是 /etc/hosts。我们试着使用 echo 命令,将一条新记录追加到这个文件的末尾。

1 | echo "127.0.0.1 myapp.local" >> /etc/hosts |

1

bash: /etc/hosts: Permission denied

看到了吗?Linux 毫不留情地拒绝了我们。这正是“最小权限原则”在起作用。因为我们当前的普通用户身份,对于神圣的 /etc 目录,只有读取的权限,没有任何写入的资格。

核心理念转变

- 从“我是管理员”到“我只是一个普通用户”:在 Windows 中,我们感觉自己是电脑的主人;在 Linux 中,我们要将自己视为系统的一位普通访客,root 用户才是真正的主人。

- 从“赋予程序一切”到“按需借用权限”:我们不会“以管理员身份运行终端”,而是在需要时,通过特定命令,为 单次操作 临时借用一下管理员的权力。

现在,我们已经亲身体会到了这堵墙的存在。在下一个小节,我们就会学习那把能临时打开这扇门的钥匙——sudo 命令。

9.2. ls -l 输出详解:彻底看懂文件权限

在上一节,我们碰壁了——尝试修改 /etc/hosts 时被无情地拒绝。但一个更重要的问题是:我们怎么知道自己 为什么 会被拒绝?或者说,我们如何查看一个文件或目录的“权责归属”呢?

在 Linux 世界里,ls -l 命令就是我们的“透视镜”,它能将文件权限的每一个细节都清晰地展示出来。

动手操作:生成并查看一个样本文件

为了进行分析,我们先在自己的主目录(~)里创建一个新的 shell 脚本文件,然后用 ls -l 来查看它的详细信息。

1 | # 在主目录创建一个名为 my_script.sh 的文件,并写入一行内容 |

1 | -rw-r--r-- 1 prorise prorise 12 Sep 17 19:55 my_script.sh |

这行看似复杂的输出,其实是一份关于 my_script.sh 的完整“身份履历”。让我们像解剖手术一样,把它逐段拆解开来。

| 部分 | 示例值 | 含义 |

|---|---|---|

| 文件类型与权限 | -rw-r--r-- | 本章核心! 描述了文件类型以及三类用户的权限。下面我们将深入讲解。 |

| 硬链接数 | 1 | 指向此文件的硬链接数量。对于新手,暂时无需深究,了解即可。 |

| 所有者 (Owner) | prorise | 第一个 prorise,表示这个文件的拥有者是 prorise 用户。 |

| 所属组 (Group) | prorise | 第二个 prorise,表示这个文件属于 prorise 用户组。 |

| 文件大小 (Size) | 12 | 文件内容的大小,单位是字节 (Bytes)。 |

| 最后修改时间 | Sep 17 19:55 | 文件内容最后一次被修改的时间。 |

| 文件名 (Name) | my_script.sh | 文件的名称。 |

小技巧: 如果想让文件大小更易读(例如显示为 12B, 15K, 20M),可以使用 ls -lh 命令,增加的 h 代表 human-readable。

9.2.1 深入 rwx 权限:文件与目录的“权责”细节

现在,我们聚焦于最复杂也最重要的第一部分:-rw-r--r--。

- 第 1 位: 文件类型。

-: 代表这是一个 普通文件 (regular file)。d: 代表这是一个 目录 (directory)。l: 代表这是一个 符号链接 (symbolic link),类似于 Windows 的快捷方式。

- 第 2-4 位: 所有者 (Owner/User) 的权限。示例中为

rw-。 - 第 5-7 位: 所属组 (Group) 的权限。示例中为

r--。 - 第 8-10 位: 其他人 (Others) 的权限。示例中为

r--。

其中的 r, w, x 分别代表三种基本权限,但它们对 文件 和 目录 的含义有所不同,理解这一点至关重要。

| 权限 | 对【文件】的含义 | 对【目录】的含义 |

|---|---|---|

r (Read) | 可以读取文件的具体内容 | 可以列出目录中包含的文件和子目录列表 (即可以使用 ls 命令) |

w (Write) | 可以修改文件的内容 | 可以在目录中 创建、删除、重命名 文件和子目录 |

x (Execute) | 可以将文件作为程序来执行 | 可以进入 (cd) 该目录 |

9.2.2 权限的“数字密码”:八进制表示法

为了更高效地设置权限(我们将在下一节的 chmod 命令中用到),Linux 提供了一种数字表示法。

r(读) = 4w(写) = 2x(执行) = 1

任何一组权限,都可以由这三个数字相加得到。让我们回头看 my_script.sh 的 -rw-r--r--:

- 所有者:

rw-=r+w+-= 4 + 2 + 0 = 6 - 所属组:

r--=r+-+-= 4 + 0 + 0 = 4 - 其他人:

r--=r+-+-= 4 + 0 + 0 = 4

所以,rw-r--r-- 这组权限的“数字密码”就是 644 . 这是 Linux 中最常见的文件权限之一。同理,对于目录和脚本,另一个常见的权限 755 (rwxr-xr-x) 意味着所有者拥有全部权限,而组用户和其他人拥有读和执行权限。

现在,我们已经完全掌握了查看和解读权限的技能。接下来,我们将学习如何使用 sudo, chmod, chown 去真正地 管理 这些权限。

9.3. 核心命令:sudo, chmod, chown

我们现在手握 ls 这个强大的诊断工具,但光会诊断还不够,我们还需要手术刀来“治病”。Linux 提供了三个核心命令来管理权限,我称它们为“权限三剑客”:sudo, chmod, chown。掌握了它们,你就掌握了修改权限的几乎所有能力。

9.3.1. sudo:安全地获取管理员权限

我们先来解决 9.1 节留下的那个问题:如何才能成功修改 /etc/hosts 文件?

答案就是使用 sudo。

sudo (superuser do) 的作用是,它允许一个被授权的用户以超级用户(也就是 root)的身份去执行 单条 命令。这是 Linux 中进行系统级操作的标准且安全的方式。

动手操作:使用 sudo 完成任务

注意一个常见陷阱:直接运行 sudo echo "..." >> /etc/hosts 是行不通的。因为重定向符号 >> 是由我们当前的、没有权限的 shell 来解释的,sudo 只对 echo 命令生效。我们需要让整个“追加内容”的操作都以 root 身份运行。

正确的做法是,我们启动一个有 root 权限的新 shell (bash),并让它来执行我们的命令:

1 | # -c '...' 的意思是让 bash 执行引号内的命令 |

执行后,系统会提示 [sudo] password for prorise:,在这里输入 你自己的用户密码(输入时屏幕上不会有任何显示),然后按回车。

现在,我们来验证一下是否成功了:

1 | # 使用 cat 命令查看文件内容 |

1

2

3

4

127.0.0.1 localhost

...

# 我们的新记录出现在了文件末尾

127.0.0.1 myapp.local

成功了!我们通过 sudo 这把钥匙,在需要的时候临时、安全地借用了 root 的权力,完成了普通用户无法完成的任务。

9.3.2. chmod:修改文件读、写、执行权限

接下来是 chmod (change mode),这是我们用来修改 rwx 权限的专用工具。

让我们回到 9.2 节创建的那个 my_script.sh 文件。通过 ls -l 我们知道,它的权限是 644 (-rw-r--r--),这意味着文件的所有者(也就是我们自己)对它并没有 执行(x)权限。

动手操作:为脚本赋予执行权限

第一步:验证问题

我们先尝试直接运行它,看看会发生什么。

1 | ./my_script.sh |

1

bash: ./my_script.sh: Permission denied

和预期一致,系统拒绝执行。

第二步:使用符号模式修复

chmod 提供了两种模式,首先是更易读的符号模式。

u(user),g(group),o(others),a(all)+(添加权限),-(移除权限),=(设置权限)

我们想为用户(u)添加执行(x)权限,命令就是:

1 | chmod u+x my_script.sh |

第三步:使用数字模式修复

更常用、更快捷的是我们在上一节学到的数字模式。如果我们想把权限设置为 755 (rwxr-xr-x),这是一个脚本和程序非常标准的权限设置。

1 | chmod 755 my_script.sh |

第四步:最终验证

我们再用 ls -l 检查一下结果,并尝试再次运行。

1 | ls -l my_script.sh |

1

2

-rwxr-xr-x 1 prorise prorise 12 Sep 17 20:35 my_script.sh

# 这次没有任何输出,也没有报错,代表脚本成功执行了

可以看到,文件的权限已经变成了 rwxr-xr-x,并且可以成功执行了。

9.3.3. chown:变更文件的所有者与用户组

最后一位成员是 chown (change owner),它用来改变文件的所有者和所属组。在你自己的开发目录中,这个命令可能用得不如 chmod 频繁,但在处理 Web 服务器文件、多人协作项目时,它至关重要。

动手操作:将 root 文件“收归己有”

第一步:制造问题

我们用 sudo 在 /tmp 目录(一个公共的临时目录)里创建一个文件。这样,文件的所有者默认就是 root。

1 | sudo touch /tmp/data.csv |

1

-rw-r--r-- 1 root root 0 Sep 17 20:55 /tmp/data.csv

现在,这个文件归 root 用户和 root 组所有,我们作为普通用户 prorise,对它只有只读权限。

第二步:验证问题

我们尝试向这个文件写入内容。

1 | echo "user_id,data" > /tmp/data.csv |

1

bash: /tmp/data.csv: Permission denied

第三步:使用 chown 修复

现在,我们使用 chown 将这个文件的所有权交还给我们自己。因为操作一个不属于我们的文件需要管理员权限,所以 chown 命令本身也需要用 sudo 来执行。

chown 的语法是 user: group

1 | sudo chown prorise:prorise /tmp/data.csv |

第四步:最终验证

我们再次检查所有权,并尝试写入。

1 | ls -l /tmp/data.csv |

1

2

-rw-r--r-- 1 prorise prorise 0 Sep 17 20:42 data.csv

user_id,data

可以看到,文件的所有者已经成功变更为 prorise,我们现在可以顺利地对它进行读写操作了。

9.4. 常见场景应用:解决日常开发中的权限问题

在上一节,我们已经掌握了 chmod 和 chown 这两把“手术刀”的基础用法。现在,我们要将它们应用到几个开发者几乎每天都会遇到的真实“战场”上。我们已经知道了如何为脚本赋予执行权限,接下来要处理的两个场景,其重要性有过之而无不及。

场景一:为 SSH 私钥设置正确的安全权限

这是每一位需要和 Git (以及 GitHub, GitLab) 或远程服务器打交道的开发者的 必修课。如果你在 WSL 中生成了新的 SSH 密钥,并尝试用它连接远程主机,很可能会遇到一个措辞严厉的报错。

痛点复现

SSH 客户端对你的私钥(例如 ~/.ssh/id_rsa)有强制性的安全要求。为了保护你的凭证不被窃取,它绝不允许你的私钥文件被除了你以外的任何用户读取。如果权限设置不当,你将看到类似这样的错误:

Permissions 0644 for '/home/prorise/.ssh/id_rsa' are too open.

这个错误明确告诉你:权限过于开放,为了安全,我拒绝工作。

动手操作:锁定你的 SSH 密钥

第一步:模拟不安全的权限

我们先手动在 ~/.ssh 目录下创建一个假的文件,并故意给它一个不安全的 644 权限。

1 | # -p 选项可以确保在目录不存在时创建它,且不会报错 |

1

-rw-r--r-- 1 prorise prorise 0 Sep 17 21:02 id_rsa_demo

rw-r--r-- 意味着所属组和其他用户都拥有 读 权限,这正是 SSH 客户端所禁止的。

第二步:应用正确的权限“铁律”

正确的权限设置有两条规则:

.ssh目录本身的权限必须是 700 (drwx------)。- 私钥文件(

id_rsa)的权限必须是 600 (-rw-------)。

让我们用 chmod 来执行这条铁律。

1 | chmod 700 ~/.ssh |

第三步:验证修复结果

我们再次使用 ls -l 来检查。注意,要查看目录本身的权限,我们需要加上 -d 选项。

1 | # 查看 .ssh 目录的权限 |

1

2

drwx------ 2 prorise prorise 4096 Sep 17 21:02 /home/prorise/.ssh

-rw------- 1 prorise prorise 0 Sep 17 21:02 /home/prorise/.ssh/id_rsa_demo

完美。现在,目录和文件的权限都变得“密不透风”,只有所有者 prorise 能够访问,SSH 客户端会完全满意。

场景二:修正 Web 服务器的目录权限

对于后端或全栈开发者来说,这是一个经典场景。你在 WSL 中部署了一个 Web 应用(例如 Laravel, Django, Express),但应用始终无法写入日志文件,或者用户上传文件失败。

问题根源

为了系统安全,Web 服务器软件(如 Nginx, Apache)通常不会以你的用户身份(prorise)运行。它们有自己专属的、低权限的用户,在 Ubuntu/Debian 系统中,这个用户通常是 www-data .

当你的项目代码目录所有者是 prorise:prorise 时,www-data 用户自然没有权限向其中的 storage 或 uploads 目录写入任何内容。

动手操作:为 Web 应用交出目录控制权

第一步:模拟项目部署场景

我们用 sudo 在 /var/www(一个 Web 项目的标准存放位置)下创建一个典型的项目结构。使用 sudo 会导致这些文件和目录的所有者默认为 root,这恰好模拟了我们用 root 权限从 Git 仓库拉取代码后忘记修改权限的常见错误。

1 | sudo mkdir -p /var/www/my-project/storage/logs |

1

drwxr-xr-x 3 root root 4096 Sep 17 21:02 /var/www/my-project/storage

可以看到,storage 目录归 root 所有。

第二步:使用 chown 移交所有权

现在,我们需要把应用需要写入的目录(这里是 storage 及其所有子文件)的所有权,全部移交给 www-data 用户和 www-data 用户组。这里 -R (recursive, 递归) 选项至关重要。

1 | sudo chown -R www-data:www-data /var/www/my-project/storage |

第三步:验证修复结果

我们再来检查一下 storage 目录的所有权。

1 | ls -ld /var/www/my-project/storage |

1

drwxr-xr-x 3 www-data www-data 4096 Sep 17 21:02 /var/www/my-project/storage

现在,当 Nginx 以 www-data 用户身份运行时,它对 storage 目录就拥有了完全的控制权,可以顺利地写入日志或上传文件了。

协作技巧:在某些情况下,你既希望 www-data 用户能写入,也希望你自己(prorise)能方便地修改这些文件。一种常见的做法是:将你自己加入到 www-data 组 (sudo usermod -aG www-data prorise),然后将目录权限设置为 775,这样组内的所有成员就都有了写入权限。

通过以上两个真实场景的演练,我们已经将基础的权限命令和实际的开发工作流紧密地结合了起来。

9.5. 用户与用户组管理:理解权限的“主语”

到目前为止,我们一直在讨论权限的“宾语”(文件和目录)以及权限本身(rwx)。但我们还没有深入探讨权限的“主语”——是谁在拥有和行使这些权力?

本节,我们就来学习如何在 Linux 中创建和管理用户与用户组。

9.5.1. 用户管理

在 Linux 中,每个用户都有一个唯一的身份(UID)和一个主要的用户组(GID)。我们来学习几个关键的命令。

动手操作:创建和管理一个新用户

第一步:创建新用户 useradd

假设我们需要为一位新加入项目的开发者 new_dev 创建一个账户。

我们会使用 useradd 命令。其中,-m 选项至关重要,它会自动为新用户在 /home/ 下创建同名主目录;-s /bin/bash 则为用户指定一个可用的登录 shell。

1 | sudo useradd -m -s /bin/bash new_dev |

第二步:验证用户创建

我们可以通过检查 /home 目录来验证用户的主目录是否已创建。

1 | ls -ld /home/new_dev |

1

drwxr-xr-x 2 new_dev new_dev 4096 Sep 17 21:25 /home/new_dev

可以看到,一个归 new_dev 用户和 new_dev 组所有的主目录已经创建好了。

第三步:设置密码 passwd

新创建的用户默认没有密码,无法登录。我们需要用 passwd 命令为他设置一个。

1 | sudo passwd new_dev |

执行后,系统会让你输入两次新密码(输入过程不可见)。

第四步:修改用户 usermod (最常用)

usermod 命令用于修改已存在的用户。其最常见的场景,就是 将一个用户添加到一个或多个附加用户组中。

例如,在 9.4 节我们提到,为了方便开发,可以把我们自己(prorise)加入到 www-data 用户组。这里的 -aG 选项是关键:-G 表示指定附加组,-a (append) 表示 追加 而不是覆盖。

1 | sudo usermod -aG www-data prorise |

我们可以用 groups 命令来验证自己所属的组。

1 | groups prorise |

1

prorise : prorise www-data

请注意:用户组的变动通常需要用户 重新登录 后才能完全生效。

9.5.2. 用户组管理

现在我们来看看如何直接管理用户组。

动手操作:创建一个项目组并添加成员

第一步:创建用户组 groupadd

假设我们要为一个名为 alpha 的项目创建一个专属的开发者用户组 alpha_devs。

1 | sudo groupadd alpha_devs |

我们可以通过 grep 命令在 /etc/group 文件中查看它是否被成功创建。

1 | grep alpha_devs /etc/group |

1

alpha_devs:x:1001:

第二步:添加用户到组 gpasswd

除了 usermod,我们还可以用 gpasswd 命令来管理组的成员。我们把刚才创建的 new_dev 用户加入到 alpha_devs 组中。

1 | sudo gpasswd -a new_dev alpha_devs |

然后验证 new_dev 现在所属的组。

1 | groups new_dev |

1

new_dev : new_dev alpha_devs

9.5.3. 实战演练:创建一个团队共享目录

现在,我们将刚才学到的所有知识串联起来,完成一个非常实际的任务:创建一个只有 alpha_devs 组的成员才能读写的项目共享目录。

第一步:创建并设置目录所有权

我们在 /srv(通常用于存放服务相关数据)下创建一个项目目录,并把它的所属组更改为 alpha_devs。

1 | sudo mkdir -p /srv/project_alpha |

第二步:设置目录权限

这是最关键的一步。我们需要让目录的 组用户 拥有和所有者一样的写入权限。因此,权限 775 (drwxrwxr-x) 是最合适的选择。

1 | sudo chmod 775 /srv/project_alpha |

第三步:最终验证

最后,我们用 ls -ld 来查看我们的成果。

1 | ls -ld /srv/project_alpha |

1

drwxrwxr-x 2 prorise alpha_devs 4096 Sep 17 21:30 /srv/project_alpha

分析这个权限 drwxrwxr-x:

- 所有者

prorise拥有完整的读、写、执行权限。 alpha_devs组的所有成员,也拥有完整的读、写、执行权限。- 其他无关用户,则只有读和进入目录的权限。

9.6. 工作流集成与常见“坑”点解析

到目前为止,我们已经完全掌握了 Linux 权限和用户管理的核心。但真正的挑战,发生在我们试图将 Windows 的图形化界面与 Linux 的命令行后端无缝结合的时候。

在这一节,我们不学习新命令,而是化身为“故障排除专家”,去解决几个你在第一天使用 WSL + VS Code 时几乎必然会遇到的“坑”。理解并解决它们,将是你从“能用”到“好用”的关键一步。

9.6.1. 痛点一:VS Code 中无法直接在浏览器中预览 HTML 文件

这是一个经典场景。你在 WSL 的项目目录里创建了一个简单的 index.html,想在 Windows 的 Chrome 或 Edge 浏览器里看看效果。于是,你在 VS Code 里右键点击文件,选择“在默认浏览器中打开 (Open in Default Browser)”…

结果,浏览器打开了,但页面却无法显示。

动手操作:复现问题

第一步:创建我们的 Web 项目

我们在主目录下创建一个简单的网站项目。

1 | mkdir -p ~/projects/my-site |

第二步:在 VS Code 中打开项目

确保你的 VS Code 已经安装了官方的 “WSL” 扩展。然后,在 WSL 终端里,进入项目目录并用 code . 打开。

1 | cd ~/projects/my-site |

VS Code 窗口会启动,并在左下角显示 “WSL: Ubuntu”,表明它已成功连接到我们的 Linux 环境。

第三步:尝试预览

在 VS Code 的文件浏览器中,右键点击 index.html,选择 “Open in Default Browser”。

你会发现,你的 Windows 浏览器被打开了,但地址栏显示的 URL 类似这样:

file:///home/prorise/projects/my-site/index.html

页面显示“找不到文件”或类似的错误。

问题根源:文件系统与网络的“边界”

这个问题的根源在于,Windows 。

- 你的 Windows 浏览器,生活在 Windows 的世界里。它能理解的本地文件路径是

C:\Users\Prorise\...这样的格式。 file:///home/prorise/...是一个 Linux 世界 的文件路径。Windows 浏览器根本不知道/home/是什么地方,自然找不到文件。

解决方案:搭建一座“网络的桥梁”—— Live Server

要跨越这个边界,我们不能直接“扔”一个文件路径过去,而要通过两个世界都能理解的通用语言——网络协议 (HTTP)。

VS Code 的 Live Server 扩展就是为此而生的。它的工作原理是:

- 在你的 WSL 环境内部,启动一个微型的、真实的 Web 服务器。

- 这个服务器会托管你的项目文件,并通过一个网络地址(例如

http://127.0.0.1:5500)来提供服务。 - WSL 2 的一大魔力在于,它会自动将 Linux 侧的

localhost(127.0.0.1) 端口 转发 到 Windows 侧。 - 因此,当你的 Windows 浏览器访问

http://127.0.0.1:5500时,请求会被无缝地传送到 WSL 内部的 Live Server,服务器再把index.html的内容返回给浏览器。

动手操作:解决问题

第一步:安装 Live Server 扩展

在 VS Code 的扩展市场里,搜索 “Live Server” 并点击安装。请确保你是在 “WSL: UBUNTU - 已安装” 这个分类下进行安装,这样扩展才会被安装到 WSL 环境中。

第二步:启动服务

安装完成后,VS Code 的右下角状态栏会出现一个 “Go Live” 按钮。点击它。

第三步:见证奇迹

你的 Windows 浏览器会自动打开,地址栏是 http://127.0.0.1:5500 (或类似端口),页面上成功显示出 “Hello from WSL!”。问题解决。

这个案例的核心启示是:当需要在 WSL 和 Windows GUI 应用之间交互时,优先考虑通过 localhost 网络端口,而不是直接的文件路径访问。这套逻辑适用于 Web 开发、连接数据库 GUI 工具等一切跨界场景。

9.6.2. 痛点二:在 /mnt/c 目录下 npm install 为什么那么慢?

这是另一个新手极易犯的错误。为了图方便,直接在挂载的 Windows 目录(例如 /mnt/c/Users/Prorise/Desktop/my-project)里进行 git clone 或 npm install。

结果就是,一个原本只需要 30 秒的 npm install,现在可能需要 5-10 分钟,速度慢到令人发指。

问题根源:跨文件系统的 I/O 开销

我们必须牢记【性能黄金法则】:项目代码和所有需要频繁读写的文件,必须存放在 Linux 的原生文件系统内(即 ~/ 主目录下的任何地方)。

- Linux 侧是高性能的

ext4文件系统。 - Windows 侧是

NTFS文件系统。 - WSL 2 通过一个名为

9P的网络协议来连接这两个文件系统。

当你在 /mnt/c 下执行 npm install 时,成千上万个小文件的创建、读取、写入操作,都需要在这个 9P 协议上“穿梭”,每一次穿梭都有额外的性能开销。积少成多,就造成了巨大的性能瓶颈。

而当你在 ~/projects 下执行同样操作时,一切都发生在原生的 ext4 文件系统内部,没有任何跨界开销,速度自然飞快。

9.6.3. 痛点三:为什么新装的程序提示“command not found”?

你在网上找了一个教程,安装了一个新的命令行工具。安装过程看起来一切顺利,但当你满怀信心地敲下那个命令时,终端却冷冰冰地返回 command not found。

问题根源:PATH 环境变量

在 Linux 中,当你在终端输入一个命令(比如 ls),shell 并不会搜遍整个硬盘去找它。它只会去一个叫做 PATH 的“地址簿”里查找。

PATH 环境变量包含了一个由冒号分隔的目录列表。shell 会依次在这些目录里寻找你输入的命令。如果找遍了所有目录都没有找到,就会报 command not found。

有些软件的安装脚本会自动把它的路径添加到 PATH 里,但有些则不会。

动手操作:诊断并解决 PATH 问题

第一步:查看当前的 PATH

用 echo 命令可以打印出你当前的 PATH 内容。

1 | echo $PATH |

1

/usr/local/sbin:/usr/local/bin:/usr/sbin:/usr/bin:/sbin:/bin:/usr/games:/usr/local/games

第二步:找到新命令的位置

假设你安装的新工具在 /opt/my-tool/bin 目录下。

第三步:临时解决

你可以通过 export 命令,临时将这个新目录添加到 PATH 中。

1 | export PATH="$PATH:/opt/my-tool/bin" |

这会将新路径追加到现有 $PATH 的末尾。这种方式只在当前的终端会话中有效,关闭窗口后就会失效。

第四步:永久解决

要让配置永久生效,你需要把上面那句 export 命令,添加到你的 shell 配置文件末尾。如果你正在使用 Zsh (如我们在第三章配置的),这个文件就是 ~/.zshrc。

1 | # 将 export 命令追加到 .zshrc 文件末尾 |

现在,你就可以在任何地方直接使用你的新命令了。

9.7. WSL 环境专属配置与优化

现在我们已经解决了几个在实际操作中遇到的“坑”,是时候从“被动修补”转向“主动预防”了。在这一节,我们将学习通过配置文件来从根本上优化 WSL 的行为,让我们的环境更贴合专业开发的需要。

我们将接触两个重要的配置项:一个是 WSL 专属的 /etc/wsl.conf 文件,另一个是 Linux 通用的 umask 设置。

9.7.1. /mnt 挂载盘的权限元数据 (Metadata)

我们在 9.6.2 节已经强调过,为了性能,代码必须放在 Linux 文件系统里。但有时,我们确实需要处理位于 Windows 盘符(例如 /mnt/c)下的文件,比如一个共享的配置文件或一个数据集。

痛点复现

当你尝试在 /mnt/c 目录下使用 chmod 时,你会发现它完全“失灵”了。

动手操作:体验 chmod 的“失效”

1 | # 进入你的 Windows C 盘用户桌面目录 |

1

-rwxrwxrwx 1 prorise prorise 0 Sep 17 21:45 wsl_test.txt

默认情况下,为了最大程度的兼容性,所有 Windows 挂载盘下的文件权限都被模拟为 777(rwxrwxrwx)。现在我们尝试修改它:

1 | chmod 600 wsl_test.txt |

1

-rwxrwxrwx 1 prorise prorise 0 Sep 17 21:45 wsl_test.txt

你会发现权限 没有任何变化,chmod 命令被无视了。

问题根源与解决方案:开启 metadata

原因是 Windows 的 NTFS 文件系统本身不支持 Linux 的 rwx 权限元数据。所以默认情况下,WSL 根本没有地方去记录你做的权限变更。

幸运的是,我们可以通过修改 /etc/wsl.conf 文件来开启这个功能。这会让 WSL 将 Linux 的权限信息作为附加元数据存储在 NTFS 文件中。

动手操作:配置 wsl.conf

第一步:编辑配置文件

我们使用 nano 编辑器来创建并编辑这个文件。它需要 sudo 权限。

1 | sudo nano /etc/wsl.conf |

第二步:添加配置内容

在打开的 nano 编辑器中,粘贴以下内容:

1 | [automount] |

然后按 Ctrl+X,接着按 Y,最后按 Enter 保存并退出。

第三步:重启 WSL (关键步骤)

这个配置需要完全重启 WSL 子系统才能生效。打开一个 Windows PowerShell 或 CMD 窗口(不是 WSL 终端),执行以下命令:

1 | wsl --shutdown |

关闭所有已打开的 WSL 终端,然后重新打开一个新的。

第四步:验证修复结果

我们再次执行之前的操作。

1 | cd /mnt/c/Users/<YourWindowsUser>/Desktop |

1

2

-rw-r--r-- 1 prorise prorise 0 Sep 17 21:50 wsl_test_new.txt

-rw------- 1 prorise prorise 0 Sep 17 21:50 wsl_test_new.txt

成功了!新创建的文件有了一个更合理的默认权限 644,并且我们的 chmod 600 命令也正确生效了。

再次强调:开启 metadata 解决了权限管理问题,但 不能 解决性能问题。日常开发的主力目录依然必须是 ~/。

9.7.2. 使用 umask 自定义新文件的默认权限

你可能已经注意到了,当我们创建一个新文件时,它的默认权限是 644 (-rw-r--r--);创建一个新目录时,默认是 755 (drwxr-xr-x)。这是由一个叫做 umask 的设置决定的。

umask (user file-creation mode mask) 像一个“遮罩”,它定义了在创建文件或目录时,需要从最大权限中“减去”哪些权限。

- 系统的最大默认权限:目录是

777,文件是666(文件默认不应有执行权限)。 - 常见的

umask值是0022。

计算过程:

- 新目录:

777-022=755(rwxr-xr-x) - 新文件:

666-022=644(rw-r--r--)

痛点与解决方案

默认的 umask 0022 对于个人开发没问题,但在团队协作中,它意味着组内其他成员无法修改你创建的文件(因为组权限是 r--)。为了方便协作,通常希望新文件的默认权限是 664 (rw-rw-r--),新目录是 775 (rwxrwxr-x)。

要达到这个效果,我们需要的 umask 值是 0002。

动手操作:修改 umask

第一步:检查当前 umask

1 | umask |

1

0022

第二步:临时修改 umask 并验证

我们可以直接在当前终端里设置新的 umask 值,并立即创建一个文件来查看效果。

1 | umask 0002 |

1

-rw-rw-r-- 1 prorise prorise 0 Sep 17 21:55 collaborative_file.txt

效果立竿见影,新文件的组权限已经包含了 w(写权限)。

第三步:永久生效

和 PATH 变量一样,直接在终端执行 umask 也是临时性的。要让它永久生效,我们需要将这个命令写入 shell 的配置文件中。

1 | # 将 umask 设置追加到 .zshrc 文件末尾 |

这样,以后你所有新打开的终端,都会自动使用 0002 这个更适合协作的 umask 值了,至此,我们已经将 WSL 环境的配置和优化调整到了一个非常舒服的状态。最后,让我们对本章的所有核心知识点进行一次全面的总结和回顾。

好的,是时候为这深入的一章画上一个完美的句号了。我们将用一张高度浓缩的速查表来巩固记忆,再通过一个模拟面试来检验我们的理解深度。

9.8. 本章核心速查总结

这张速查表浓缩了本章所有的核心命令和关键实践,你可以将它作为日后快速回顾的索引。

| 分类 | 关键项 | 核心描述 |

|---|---|---|

| 权限诊断 | ls -l <path> | (高频) 以长列表形式,查看文件/目录的权限、所有者、大小等详细信息。 |

| 权限执行 | sudo <command> | (高 PIN) 以 root 超级用户身份执行单条命令,是进行系统级操作的标准方式。 |

| 权限修改 | chmod [mode] <path> | 修改文件/目录的 rwx 权限。模式(mode)可以是数字 (755) 或符号 (u+x)。 |

| 所有权修改 | chown [user]:[group] <path> | (配合 sudo) 变更文件/目录的所有者和所属组。-R 参数可递归操作。 |

| 用户管理 | useradd -m <user> | 创建一个新用户,并为其自动创建主目录。 |

usermod -aG <group> <user> | (高频) 将一个已存在用户 追加 到一个附加组中,-a 参数是关键。 | |

passwd <user> | 为用户设置或修改密码。 | |

| 用户组管理 | groupadd <group> | 创建一个新的用户组。 |

gpasswd -a <user> <group> | 将一个用户添加到一个组中。 | |

| 环境配置 | /etc/wsl.conf | WSL 专属配置文件,用于调整挂载、网络等行为。metadata 选项是关键。 |

umask [value] | 设置新建文件和目录的默认权限“遮罩”。0002 是适合团队协作的值。 |

核心理念与最佳实践回顾

- 最小权限原则: 这是 Linux 安全的基石。永远以普通用户身份工作,只在绝对必要时使用

sudo临时获取权限。 - WSL 性能黄金法则: 项目代码 永远 存放在 Linux 原生文件系统 (

~/projects),绝不 放在/mnt/c等 Windows 挂载盘下进行 I/O 密集型操作。 - 跨界交互靠网络: 当 WSL 需要与 Windows GUI 应用(浏览器、数据库工具等)交互时,首选方案是通过

localhost端口转发,而不是直接的文件路径。 - SSH 密钥权限铁律:

~/.ssh目录权限必须为700,私钥文件(如id_rsa)权限必须为600。

第十章:进程与服务管理:化身系统指挥官

摘要: 在前面的章节中,我们已经搭建并优化了开发环境。然而,一个真正的工匠不仅要会使用工具,更要能洞察工具箱内部的运作状态。本章将带你深入 Linux 的“引擎室”——进程与服务管理。我们将学习如何精准地定位、诊断和管理系统中的每一个活动进程,掌握与它们“沟通”的正确方式。更重要的是,我们将攻克“终端关闭,任务中断”、“端口被占用”等一系列开发者日常的最高频痛点,并最终学会使用现代化的 systemd,像一个真正的运维专家那样,管理需要长期稳定运行的后台服务。

本章学习地图:

在本章中,我们将循序渐进,建立对系统活动全局掌控的能力:

- 首先,我们将掌握进程的 侦查与诊断,学会如何从系统的万千活动中,快速定位到我们关心的目标。

- 接着,我们将学习 信号的艺术,理解如何与进程进行“优雅”或“强制”的沟通,确保服务的平稳启停。

- 然后,我们将攻克开发者最常见的痛点:任务的持久化,使用

nohup和终极武器tmux构建一个永不掉线的开发会话。 - 之后,我们将化身 网络侦探,解决“端口被占用”这一高频难题。

- 最后,我们将接触现代 Linux 系统的基石——systemd 服务管理,学习像运维专家一样管理和部署后台应用。

10.1. 侦查与诊断:透视系统脉搏

痛点背景:

想象这个场景:你的应用突然响应迟缓,系统风扇狂转,CPU 负载升高;或者,你刚刚在后台启动了一个数据处理脚本,现在想确认它是否还在正常运行。在这些时刻,我们首先需要一套精准的侦查工具来定位问题进程,看穿系统当前的脉搏。

静态快照: 经典组合拳 ps aux | grep

ps (process status) 是查看进程状态的基石命令。它会给你拍下一张当前系统进程的“静态快照”。单独使用 ps 信息有限,我们通常会附带 aux 选项:

a: 显示所有用户的进程。u: 以用户为中心,显示更详细的信息。x: 同时显示没有控制终端的进程(比如系统后台服务)。

动手操作:初探进程列表

直接运行 ps aux 会输出海量的信息,通常我们会用管道符 | 将结果传递给 grep 来进行过滤。例如,我们想查找 WSL 自带的 SSH 服务进程 sshd。

1 | ps aux | grep sshd |

1

2

root 10 0.0 0.0 8892 4884 ? Ss Sep17 0:00 /usr/sbin/sshd -D

prorise 1234 0.0 0.0 6836 2248 pts/0 S+ 22:05 0:00 grep --color=auto sshd

这个输出告诉我们很多信息:

- 第一行就是我们想找的

/usr/sbin/sshd服务进程,它的所有者是root,进程 ID (PID) 是10。PID 是进程的唯一身份证号,后续我们与进程交互都将依赖它。 - 第二行是

grep命令本身。因为我们执行的grep sshd这个动作本身也是一个进程,所以它也被自己找到了。这是一个经典的小干扰。

实时仪表盘: htop (top 的终极替代品)

ps 提供的都是“静态快照”,如果你想实时监控系统状态,就需要一个动态的“仪表盘”。传统的工具是 top,但它的界面简陋,操作也不够直观。在 2025 年,我们毫无疑问应该选择它的终极替代品:htop .

htop 提供了一个彩色的、可交互的界面,让你能用更直观的方式排序、过滤、甚至直接管理进程。

动手操作:安装并体验 htop

第一步:安装 htop

htop 通常不是默认安装的,我们需要手动安装一下。

1 | sudo apt update && sudo apt install htop -y |

第二步:启动 htop

直接在终端输入命令即可。

1 | htop |

你的整个终端窗口会被 htop 的交互界面接管。

htop 核心功能导览

你不需要记住所有功能,但以下几个是开发者排查问题的“利器”:

- 实时监控: 顶部的 CPU(每个核心一个进度条)、Mem(内存)、Swp(交换空间)使用率让你对系统负载一目了然。

- 排序: 用鼠标直接点击

CPU%或MEM%这些列标题,或者按 F6,可以快速找到最耗费资源的应用。 - 过滤 (F4): 按下

F4,在底部输入sshd,进程列表会立即只显示与sshd相关的进程。 - 树状视图 (F5): 按下

F5,进程会以树状结构展示,清晰地显示出谁是谁的父进程,对于理解复杂应用的进程关系非常有帮助。 - 发送信号/杀死进程 (F9): 选中一个进程,按下

F9,会弹出一个信号菜单(我们下一节会详细讲),你可以选择发送SIGTERM(15) 来优雅地关闭它,或者在它卡死时发送SIGKILL(9) 来强制终结。

当你完成侦查后,按下 q 或 F10 即可退出 htop。

现在,我们已经掌握了从静态到动态、从粗略到精确的各种进程侦查手段。接下来,我们将学习如何使用这些侦查结果,与进程进行“沟通”。

10.2. 信号的艺术:与进程的优雅沟通

痛点背景: 想象一下,一个正在向数据库写入重要数据的应用程序,或者一个正在处理用户上传文件的大型 Web 服务。如果此时我们粗暴地“拔掉电源”,极有可能导致数据文件损坏、数据库记录不一致或产生难以清理的临时文件。我们需要一种机制,能够通知进程:“请准备一下,你即将关闭”,让它有机会完成收尾工作,这就是 Linux 信号机制的价值所在。

10.2.1. 核心信号理论

信号 (Signal) 是 Linux/Unix 系统中进程间通信的一种基本方式。它是一个异步的通知,由内核发送给某个进程,以告知其发生了某个事件。进程可以捕获并处理大部分信号,执行自定义的清理逻辑。对于开发者和系统管理员而言,必须掌握以下三个最关键的信号: